Code

!pip install dldna[colab] # in Colab

# !pip install dldna[all] # in your local

%load_ext autoreload

%autoreload 2“La eficiencia es el puente hacia la inteligencia.” - Alan Turing

Desde la aparición de los Transformers en 2017, han surgido sucesivamente modelos de lenguaje grandes representados por BERT y GPT. Estos modelos han abierto una nueva era en la inteligencia artificial con sus sorprendentes rendimientos. Sin embargo, detrás de este éxito se encontraban las limitaciones fundamentales de la arquitectura de los Transformers y los esfuerzos para superarlas. Se realizaron mejoras constantes y propuestas estructurales para superar problemas de complejidad computacional y limitaciones en el procesamiento de textos largos. En particular, desde 2019, con el rápido aumento del tamaño de los modelos, se ha intensificado la investigación sobre eficiencia.

Cambios principales por período:

En este capítulo examinaremos las limitaciones de los Transformers y detallaremos diversas soluciones para superarlas.

Desafío: ¿Cómo reducir la complejidad computacional y el uso de memoria del modelo Transformer, procesar contextos más largos y entrenar modelos más grandes?

Angustia del investigador: Aunque el rendimiento de los modelos Transformer era sobresaliente, su costo computacional era enorme. En particular, el mecanismo de atención tenía una complejidad proporcional al cuadrado de la longitud de la secuencia, lo que limitaba severamente la escalabilidad del modelo. Los investigadores tenían que encontrar formas de aumentar la eficiencia computacional mientras mantenían las funciones esenciales de la atención. No se trataba simplemente de reducir el tamaño del modelo, sino de buscar soluciones innovadoras a nivel de algoritmos y hardware. Esto era un desafío similar a construir un edificio enorme mientras se reducía el peso y el costo de cada ladrillo.

La complejidad cuadrática de la operación de atención, las longitudes limitadas de contexto y los problemas de eficiencia en memoria fueron los principales obstáculos para la expansión del modelo. Estas limitaciones se convirtieron en factores cruciales que determinaron la dirección del desarrollo de los Transformers.

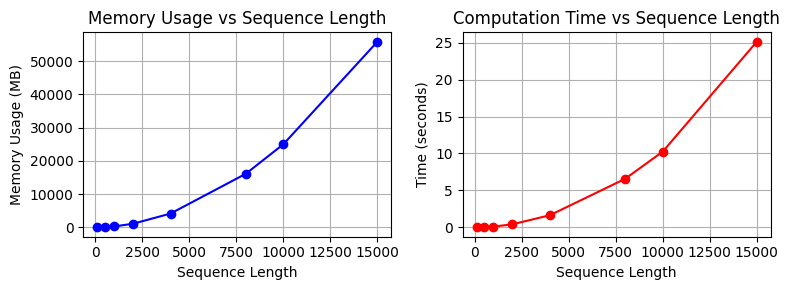

Durante el proceso de escalado de modelos Transformer, la complejidad de las operaciones de atención, particularmente la proporcional a la longitud cuadrática de la secuencia, fue un gran problema.

Análisis de la complejidad de la operación de atención:

\(Attention(Q, K, V) = softmax(\frac{QK^T}{\sqrt{d_k}})V\)

Vamos a ver esto en código para observar la velocidad de ejecución y el uso de memoria.

!pip install dldna[colab] # in Colab

# !pip install dldna[all] # in your local

%load_ext autoreload

%autoreload 2from dldna.chapter_09.complexity_benchmark import measure_attention_complexity, plot_complexity_analysis, measure_attention_complexity_gpu

seq_lengths = [100, 500, 1000, 2000, 4000, 8000, 10000, 15000]

results = measure_attention_complexity(seq_lengths=seq_lengths)

print("\n=== Complexity Analysis of Attention Operation ===")

print("\nMemory usage and execution time by sequence length:")

print("Length\t\tMemory (MB)\tTime (seconds)")

print("-" * 40)

for seq_len, mem, time_taken in results:

print(f"{seq_len}\t\t{mem:.2f}\t\t{time_taken:.4f}")

# Visualize with a graph

plot_complexity_analysis(results)

=== Complexity Analysis of Attention Operation ===

Memory usage and execution time by sequence length:

Length Memory (MB) Time (seconds)

----------------------------------------

100 18.75 0.0037

500 96.58 0.0388

1000 317.00 0.1187

2000 1119.00 0.4228

4000 4188.14 1.6553

8000 16142.53 6.5773

10000 25039.31 10.2601

15000 55868.54 25.1265

En los modelos de transformador reales, esta operación se repite a través de múltiples capas. El aumento del tamaño del lote también aumenta la cantidad de cálculos.

# Compare theoretical complexity with actual measurements

print("\n=== Comparison of Theoretical Complexity and Actual Measurements ===")

base_seq = seq_lengths[0]

base_mem = results[0][1]

base_time = results[0][2]

print("\nTheoretical vs Actual Growth Rate (Base: First Sequence Length)")

print("Length Theoretical(N²) Actual Memory Actual Time")

print("-" * 60)

for seq_len, mem, time_taken in results:

theoretical = (seq_len/base_seq) ** 2

actual_mem = mem/base_mem

actual_time = time_taken/base_time

print(f"{seq_len:6d} {theoretical:10.2f}x {actual_mem:10.2f}x {actual_time:10.2f}x")

=== Comparison of Theoretical Complexity and Actual Measurements ===

Theoretical vs Actual Growth Rate (Base: First Sequence Length)

Length Theoretical(N²) Actual Memory Actual Time

------------------------------------------------------------

100 1.00x 1.00x 1.00x

500 25.00x 5.15x 8.05x

1000 100.00x 16.91x 32.49x

2000 400.00x 59.71x 124.52x

4000 1600.00x 223.34x 474.71x

8000 6400.00x 860.92x 1882.04x

10000 10000.00x 1335.43x 2976.84x

15000 22500.00x 2979.67x 7280.40xLa complejidad cuadrática es particularmente grave en modelos a gran escala como GPT-3. Esto ha llevado a numerosas limitaciones, como la restricción de procesamiento de documentos largos y el límite de tamaño de lote durante el entrenamiento. Esta situación se convirtió en un motivo principal para desarrollar mecanismos de atención más eficientes.

Los primeros intentos para abordar el problema de complejidad cuadrática en los transformadores tomaron principalmente tres direcciones.

Atención con ventana deslizante

Calcula la atención solo dentro de una ventana de tamaño fijo.

def sliding_window_attention(q, k, v, window_size):

"""Sliding window attention"""

batch_size, seq_len, dim = q.shape

attention_weights = np.zeros((batch_size, seq_len, seq_len))

for i in range(seq_len):

start = max(0, i - window_size // 2)

end = min(seq_len, i + window_size // 2 + 1)

scores = np.matmul(q[:, i:i+1], k[:, start:end].transpose(0, 2, 1))

attention_weights[:, i, start:end] = softmax(scores, axis=-1)

return np.matmul(attention_weights, v)Este método reduce la complejidad a \(O(N \cdot w)\) (w: tamaño de la ventana).

Patrón de atención dispersa

El patrón de atención dispersa es un enfoque que, en lugar de calcular las relaciones entre todas las parejas de tokens, solo calcula algunas relaciones según ciertos patrones. Por ejemplo, si tenemos una secuencia compuesta por 10 tokens, la atención normal calcularía 100 (10×10) relaciones, pero la atención dispersa solo calculará un subconjunto de estas.

def sparse_block_attention(q, k, v, block_size):

"""Block sparse attention

Example: seq_len=8, block_size=2

Process the sequence in 4 blocks of 2 tokens each

Block 1 (0,1), Block 2 (2,3), Block 3 (4,5), Block 4 (6,7)

"""

batch_size, seq_len, dim = q.shape # e.g., (1, 8, 64)

num_blocks = seq_len // block_size # e.g., 8/2 = 4 blocks

attention_weights = np.zeros((batch_size, seq_len, seq_len))

for i in range(num_blocks):

# e.g., when i=0, process Block 1 (0,1)

start_q = i * block_size # 0

end_q = (i + 1) * block_size # 2

for j in range(num_blocks):

# e.g., when j=0, attention with Block 1 (0,1)

start_k = j * block_size # 0

end_k = (j + 1) * block_size # 2

# Calculate attention between tokens in Block 1 (0,1) and Block 1 tokens (0,1)

scores = np.matmul(

q[:, start_q:end_q], # (1, 2, 64)

k[:, start_k:end_k].transpose(0, 2, 1) # (1, 64, 2)

) # Result: (1, 2, 2)

# Store weights block by block

attention_weights[:, start_q:end_q, start_k:end_k] = softmax(scores, axis=-1)

# Generate the final context vectors

return np.matmul(attention_weights, v)Aproximación de rango bajo

La aproximación de rango bajo es una técnica que representa matrices grandes como el producto de matrices más pequeñas. Por ejemplo, en una oración con 10 tokens, la atención general calcula 10×10=100 relaciones, mientras que la aproximación de rango bajo las representa como el producto de dos matrices de 10×4 y 4×10 (rango=4). De esta manera, se obtienen resultados similares con solo 80 operaciones en lugar de 100.

def low_rank_attention(q, k, v, rank):

"""Low-rank attention

Example: seq_len=10, dim=64, rank=16

Project Q, K from 64 dimensions to 16 dimensions to reduce computation

"""

batch_size, seq_len, dim = q.shape # e.g., (1, 10, 64)

# Create projection matrices to project from 64 dimensions to 16 dimensions

projection_q = np.random.randn(dim, rank) / np.sqrt(rank) # (64, 16)

projection_k = np.random.randn(dim, rank) / np.sqrt(rank)

# Project Q, K to 16 dimensions

q_low = np.matmul(q, projection_q) # (1, 10, 16)

k_low = np.matmul(k, projection_k) # (1, 10, 16)

# Calculate attention in the lower dimension (operations on 10x16 matrices)

attention = np.matmul(q_low, k_low.transpose(0, 2, 1)) # (1, 10, 10)

attention_weights = softmax(attention, axis=-1)

# Generate the final context vectors

return np.matmul(attention_weights, v) # (1, 10, 64)Este método puede reducir la complejidad a \(O(N \cdot r)\). Aquí, \(r\) es el rango utilizado en la aproximación. Vamos a calcular la eficiencia de cada método.

from dldna.chapter_09.attention_complexity_examples import calcualte_efficieny

calcualte_efficieny()Original input shape: (2, 8, 4)

1. Sliding Window Attention

Output shape: (2, 8, 4)

Output of the first batch, first token: [-0.78236164 0.22592055 -1.03027549 1.13998368]

2. Block Sparse Attention

Output shape: (2, 8, 4)

Output of the first batch, first token: [-1.66095776 0.76700744 -0.45857165 -0.77422867]

3. Low-Rank Attention

Output shape: (2, 8, 4)

Output of the first batch, first token: [ 0.51121005 0.66772692 -0.77623488 -0.0323534 ]

Memory Usage Comparison (Relative Size):

Full Attention: 64

Sliding Window: 32

Block Sparse: 64

Low Rank: 32Sin embargo, los primeros intentos mostraron limitaciones como la pérdida de información, la complejidad de implementación y el deterioro del rendimiento. Google se enfocó en la aproximación de rango bajo, mientras que Microsoft centró sus esfuerzos en el desarrollo de patrones dispersos. Posteriormente, estos enfoques iniciales evolucionaron hacia un método híbrido que aprovecha tanto la dispersidad como las características de rango bajo.

Otra limitación importante es la eficiencia de memoria. Particularmente en modelos de lenguaje a gran escala, existen las siguientes cargas de memoria.

En primer lugar, la carga de memoria causada por el caché KV (Key-Value). Durante el proceso de generación autoregresiva, se deben almacenar los valores de Key y Value de los pasos temporales anteriores, lo cual aumenta linealmente con la longitud de la secuencia. Por ejemplo, en el caso de GPT-3, al procesar 2048 tokens, se requiere aproximadamente 16MB de caché KV por cada capa. En segundo lugar, los requisitos de memoria del proceso de retropropagación. El transformer almacena los valores de activación intermedios (activation value) - los resultados de cálculos intermedios que ocurren en la capa de atención (valores transformados Q, K, V, scores de atención, salidas softmax, etc.) - lo cual aumenta drásticamente a medida que se incrementa el número de capas. En el caso de BERT-large, incluso con un solo lote, se requerían aproximadamente 24GB de memoria. En tercer lugar, el uso de memoria por las operaciones de atención en sí mismas. La matriz de scores de atención tiene un tamaño proporcional al cuadrado de la longitud de la secuencia, lo que puede ser un cuello de botella grave al procesar documentos largos.

Para abordar estos problemas de memoria, se han propuesto técnicas de optimización como el checkpointing de gradientes, el entrenamiento con precisión mixta y FlashAttention.

Para superar las limitaciones de complejidad computacional y eficiencia de memoria discutidas en las secciones 9.1.1 y 9.1.2, los investigadores han desarrollado diversas técnicas para mejorar la eficiencia y escalabilidad. Estas técnicas han hecho que los modelos transformer sean más potentes y prácticos, y han tenido un gran impacto en el campo del aprendizaje profundo.

En este capítulo, presentamos un resumen de las tendencias temporales en el desarrollo del transformer, introduciendo las principales tecnologías y modelos de cada período, como se muestra en la siguiente tabla.

Tabla: Tendencias temporales en el desarrollo del transformer, modelos/técnicas clave, contenido principal, ADN del aprendizaje profundo | Sección | Período (aproximado) | Principales modelos/técnicas | Contenido y explicación clave | ADN del aprendizaje profundo | |———–|———————–|————————————|————————————–|———————————–| | 9.1 | 2017-2018 | Transformer | Introducción de un mecanismo de Attention para superar las limitaciones de los RNN y CNN tradicionales.

Innovación en modelos sequence-to-sequence | Mecanismo de Attention: Proporciona una nueva forma de enfocarse en partes importantes de los datos | | 9.2 | 2019-2020 | Performer, Sparse Transformer, Longformer

Reformer, BigBird | Enfoque de software para reducir la complejidad computacional.

Atención lineal: Aproximación del cálculo de atención (Performer).

Atención dispersa: Aplicación de atención solo a ciertas pares de tokens (Sparse Transformer, Longformer).

Atención local-global: Combinación de información local y global (Reformer, BigBird) | Atención eficiente: Esfuerzos para mantener las ventajas de la atención mientras se reduce la complejidad computacional.

Dependencias a larga distancia: Mejoras en la estructura para manejar contextos largos efectivamente | | 9.3 | 2021-2022 | FlashAttention, MQA, GQA, PagedAttention, vLLM | Enfoques de hardware y software para mejorar la eficiencia en memoria.

FlashAttention: Uso de la jerarquía de memoria GPU, tiling, procesamiento por bloques.

MQA/GQA: Optimización de consultas, compartición Key/Value.

Optimización del caché KV: PagedAttention, vLLM | Optimización de hardware: Métodos eficientes de cálculo considerando la estructura de memoria GPU.

Procesamiento paralelo: Aumento de la eficiencia en el procesamiento a través de compartición de consultas | | 9.4 | 2022-2023 | Claude-2, LongLoRA, Constitutional AI, RLHF,

RLAIF, Atención jerárquica, Memoria recurrente | Arquitecturas para la escalabilidad y fines específicos.

Contexto largo: Atención jerárquica, Transformador de memoria recurrente.

Ética/seguridad: Atención basada en reglas, ajustes basados en aprendizaje por refuerzo | Contexto largo: Evolución de la estructura del modelo para manejar contextos más largos.

Ajuste fino: Métodos para ajustar el modelo a fines específicos | | 9.5 | 2022-2023 | Codificador eficiente (basado en FlashAttention) | Clasificación de texto (AG News), FlashAttention, Pre-LN, Gradient Checkpointing, Entrenamiento con precisión mixta | Implementación: Uso de un codificador eficiente | | 9.6 | 2023 | Mistral, Decodificador eficiente (basado en GQA y Atención de ventana deslizante) | Análisis del modelo Mistral: GQA, Atención de ventana deslizante, RoPE, caché KV.

Ejemplos de aplicación: Conversión número-texto, conversión de lenguaje natural-SQL (generación de código), generación de texto-código. | Implementación: Arquitectura de decodificador eficiente | | 9.7 | 2024 | Gemma | Modelo abierto para mejorar la eficiencia y el acceso | Modelo abierto: Mejora del acceso a la investigación y al desarrollo | | 9.8 | 2024 | Phi-3 | LLM pequeño pero eficiente | Implementación: Potente SLM (Small Language Model) | La estructura de este capítulo es la siguiente:

Desde 2019 hasta 2020, se realizaron varios intentos para reducir la complejidad computacional de los transformers. Particularmente, el desarrollo durante este período liderado por Google Research y DeepMind mejoró significativamente la eficiencia de las operaciones de atención.

A principios de 2020, el equipo de Google Research logró reducir la complejidad de la atención de O(N²) a O(N) mediante FAVOR+ (Fast Attention Via positive Orthogonal Random features). FAVOR+ es el mecanismo central del modelo Performer y fue el primer método que permitió procesar secuencias largas de manera práctica.

La idea clave detrás de FAVOR+ comienza con el truco del kernel. El truco del kernel reinterpreta la atención softmax de la siguiente manera:

\(Attention(Q,K,V) = softmax(\frac{QK^T}{\sqrt{d}})V\)

Esto puede aproximarse utilizando una función kernel φ(x) que toma valores positivos de la siguiente manera:

\(Attention(Q,K,V) ≈ \frac{\phi(Q)\phi(K)^TV}{\phi(Q)\phi(K)^T\mathbf{1}}\)

La clave es reinterpretar la atención softmax en forma fraccionaria y utilizar una función kernel φ(x) para reorganizar el orden de las multiplicaciones matriciales. Es similar a cambiar \((a \times b) \times c\) por \(a \times (b \times c)\).

import numpy as np

def kernel_attention(Q, K, V, feature_dim=256): # Q: (seq_len, d_model) K: (seq_len, d_model) V: (seq_len, d_model)

# 1. Generate random projection matrix

projection = np.random.randn(Q.shape[-1], feature_dim) / np.sqrt(feature_dim)

# projection: (d_model, feature_dim)

# 2. Project Q, K to lower dimension and apply ReLU

Q_mapped = np.maximum(0, np.dot(Q, projection)) # phi(Q)

# Q_mapped: (seq_len, feature_dim)

K_mapped = np.maximum(0, np.dot(K, projection)) # phi(K)

# K_mapped: (seq_len, feature_dim)

# 3. Calculate numerator: phi(Q)phi(K)^TV

KV = np.dot(K_mapped.T, V) # (feature_dim, V_dim)

# KV: (feature_dim, d_model)

numerator = np.dot(Q_mapped, KV) # (seq_len, V_dim)

# numerator: (seq_len, d_model)

# 4. Calculate denominator: phi(Q)phi(K)^T1

K_sum = np.sum(K_mapped, axis=0, keepdims=True) # (1, feature_dim)

# K_sum: (1, feature_dim)

denominator = np.dot(Q_mapped, K_sum.T) # (seq_len, 1)

# denominator: (seq_len, 1)

# 5. Final attention output

attention_output = numerator / (denominator + 1e-6)

# attention_output: (seq_len, d_model)

return attention_output

# Example usage

seq_len, d_model = 1000, 64

Q = np.random.randn(seq_len, d_model)

K = np.random.randn(seq_len, d_model)

V = np.random.randn(seq_len, d_model)

# Calculate attention with O(N) complexity

output = kernel_attention(Q, K, V)

print(output)[[-0.00705502 -0.01553617 -0.01976792 ... -0.00906909 0.02983678

0.0424082 ]

[-0.00201811 -0.01741265 -0.00458378 ... -0.02578894 0.04247468

0.03793401]

[-0.01130314 -0.02011524 -0.00962334 ... -0.01348429 0.04382548

0.01967338]

...

[ 0.00180466 -0.01818735 -0.02244794 ... -0.01978542 0.03202302

0.03887265]

[-0.00421543 -0.01679868 -0.00537492 ... -0.00314385 0.05363415

0.03304721]

[ 0.00107896 -0.02042812 -0.01947976 ... -0.00557582 0.04534007

0.04408479]]Las tres cambios clave introducidos por FAVOR+ son los siguientes:

Los pasos de procesamiento de FAVOR+ son los siguientes:

import numpy as np

def favor_plus_attention(q, k, v, feature_dim=256):

"""FAVOR+ attention implementation

Args:

q: Query tensor (batch_size, seq_len, d_model)

k: Key tensor (batch_size, seq_len, d_model)

v: Value tensor (batch_size, seq_len, d_model)

feature_dim: The number of dimensions of the low-dimensional feature space

"""

d_model = q.shape[-1]

# 1. Generate an orthonormal random projection matrix

random_matrix = np.random.randn(d_model, feature_dim)

q_orth, _ = np.linalg.qr(random_matrix)

projection = q_orth / np.sqrt(feature_dim) # (d_model, feature_dim)

# 2. Project Q, K to the low-dimensional feature space and apply ReLU

q_prime = np.maximum(0, np.matmul(q, projection)) # (batch_size, seq_len, feature_dim)

k_prime = np.maximum(0, np.matmul(k, projection)) # (batch_size, seq_len, feature_dim)

# 3. Calculate linear-time attention

# Use einsum to perform matrix multiplication while maintaining the batch dimension

kv = np.einsum('bsf,bsd->bfd', k_prime, v) # (batch_size, feature_dim, d_model)

# Calculate the numerator

numerator = np.einsum('bsf,bfd->bsd', q_prime, kv) # (batch_size, seq_len, d_model)

# Calculate the denominator (normalization term)

k_sum = np.sum(k_prime, axis=1, keepdims=True) # (batch_size, 1, feature_dim)

denominator = np.einsum('bsf,bof->bso', q_prime, k_sum) # (batch_size, seq_len, 1)

# 4. Calculate the final attention output

attention_output = numerator / (denominator + 1e-6) # (batch_size, seq_len, d_model)

return attention_output

# Example usage

batch_size, seq_len, d_model = 2, 100, 512

q = np.random.randn(batch_size, seq_len, d_model)

k = np.random.randn(batch_size, seq_len, d_model)

v = np.random.randn(batch_size, seq_len, d_model)

output = favor_plus_attention(q, k, v)

print("Output tensor shape:", output.shape)Output tensor shape: (2, 100, 512)FAVOR+ tiene las siguientes ventajas:

Fundamento matemático

El fundamento matemático de FAVOR+ se basa en el teorema auxiliar de Johnson-Lindenstrauss. El punto clave es que las relaciones de distancia entre los datos se mantienen casi intactas cuando se proyectan de una dimensión alta a una dimensión baja. Es decir, si se reduce la dimensionalidad de 1000 a 100, las distancias relativas entre los datos no cambian significativamente.

El éxito de FAVOR+ ha impulsado el desarrollo de diversas formas de attention lineal, como Linear Transformer y Linear Attention Transformer, desempeñando un papel crucial en el procesamiento de secuencias largas.

En 2019, OpenAI introdujo patrones de dispersión fijos con el Sparse Transformer. Este método calcula solo algunas relaciones según un patrón específico en lugar de calcular las relaciones entre todas las parejas de tokens.

Patrones fijos del Sparse Transformer

El Sparse Transformer utiliza dos patrones de dispersión principales:

Estos patrones se pueden expresar matemáticamente como sigue:

\(Attention(Q,K,V) = softmax(\frac{QK^T \odot M}{\sqrt{d_k}})V\)

Aquí, M es la matriz de máscara dispersa, y ⊙ denota el producto elemento a elemento. La matriz de máscara indica qué pares de tokens deben (1) o no deben (0) recibir atención.

Este enfoque mejoró la eficiencia computacional, pero presentaba la desventaja de que los patrones eran fijos y no podían adaptarse flexiblemente según el contexto.

Combinación local-global del Longformer

En 2020, Allen AI propuso un patrón disperso más flexible con el Longformer. El Longformer utiliza un enfoque híbrido que combina atención local y atención global:

Este enfoque permite considerar tanto el contexto local como el global, lo que facilita una comprensión más rica del contexto.

Traducción:

| Título | Descripción |

|---|---|

| Ejemplo 1 | Este es un ejemplo de texto en español. No se deben traducir las expresiones matemáticas como \(x^2 + y^2 = z^2\). |

| Ejemplo 2 | Otra fila con contenido que no debe ser modificado, incluyendo código o negrita. |

import numpy as np

def longformer_attention(q, k, v, window_size=3, global_tokens=[0]):

"""Longformer attention implementation

Args:

q, k, v: (batch_size, seq_len, d_model)

window_size: Size of the local attention window

global_tokens: List of token indices to perform global attention on

"""

batch_size, seq_len, d_model = q.shape

attention_weights = np.zeros((batch_size, seq_len, seq_len))

# 1. Local attention: sliding window

for i in range(seq_len):

# Calculate window range

window_start = max(0, i - window_size)

window_end = min(seq_len, i + window_size + 1)

window_size_current = window_end - window_start

# Calculate attention scores within the window

scores = np.matmul(q[:, i:i+1], k[:, window_start:window_end].transpose(0, 2, 1))

# scores: (batch_size, 1, window_size_current)

attention_weights[:, i:i+1, window_start:window_end] = scores

# 2. Global attention: specific tokens attend to all tokens

for global_idx in global_tokens:

# Calculate attention scores for global tokens

scores = np.matmul(q[:, global_idx:global_idx+1], k.transpose(0, 2, 1))

# scores: (batch_size, 1, seq_len)

attention_weights[:, global_idx:global_idx+1, :] = scores

attention_weights[:, :, global_idx:global_idx+1] = scores.transpose(0, 2, 1)

# 3. Apply softmax (row-wise)

attention_weights = np.exp(attention_weights) / np.sum(np.exp(attention_weights), axis=-1, keepdims=True)

# 4. Calculate the final output by applying weights

output = np.matmul(attention_weights, v) # (batch_size, seq_len, d_model)

return output

# Example usage

batch_size, seq_len, d_model = 2, 10, 64

q = np.random.randn(batch_size, seq_len, d_model)

k = np.random.randn(batch_size, seq_len, d_model)

v = np.random.randn(batch_size, seq_len, d_model)

output = longformer_attention(q, k, v, window_size=2, global_tokens=[0])

print(output)[[[-0.72195324 0.03196266 -0.06067346 ... 0.57106283 1.31438

0.63673636]

[-1.72619367 -0.39122625 0.91285828 ... -1.4031466 1.2081069

0.95934394]

[ 0.07427921 0.42596224 -0.44545069 ... 0.154228 0.37435003

-0.01884786]

...

[ 1.26169539 -0.58215291 2.00334263 ... 1.15338425 0.31404728

-1.33672458]

[ 0.96005607 0.39904084 0.5703471 ... -0.2168805 0.93570179

0.05680507]

[ 0.61648602 -0.12874142 1.09736967 ... 0.32421211 1.23082505

0.4141766 ]]

[[ 0.92762851 0.26334678 -0.81047846 ... -0.19186621 0.42534117

0.57313974]

[ 1.01307261 0.61571205 -1.26925081 ... -0.56016688 -0.19707427

2.49452497]

[-1.0071559 2.81291178 2.5010486 ... 1.63559632 -0.60892113

-1.40952186]

...

[-1.96615634 1.85881047 0.19361453 ... 1.21044747 -0.00772792

-0.68961122]

[ 0.09090778 1.94770672 -0.990489 ... -0.09841141 0.65195305

0.11634795]

[-2.43256801 1.66319642 0.23557316 ... 2.39325846 0.8750332

0.66295002]]]Optimización de operaciones de matrices dispersas por bloques

Para implementar eficientemente el enfoque híbrido del Longformer, es necesario optimizar las operaciones de matrices dispersas por bloques.

El enfoque basado en patrones dispersos redujo la complejidad a O(N log N) o O(N), pero presentó desafíos de implementación y optimización de hardware.

A principios de 2020, Google Research y Allen AI propusieron un enfoque híbrido que combinaba atención local y global para abordar la pérdida de información en la atención lineal y la complejidad de implementación en patrones dispersos.

Reformer utiliza hashing sensible a la localidad (Locality-Sensitive Hashing, LSH) para agrupar eficientemente vectores similares. El principio clave del LSH es el siguiente.

\(h(x) = \text{argmax}( [xR; -xR] )\)

Aquí, R es una matriz de proyección aleatoria y los vectores similares tienen una alta probabilidad de tener el mismo valor hash. Reformer sigue los siguientes pasos.

Este método es eficiente para procesar secuencias largas, pero existe la posibilidad de pérdida de información debido a colisiones hash.

BigBird combinó tres patrones de atención para superar las limitaciones del Reformer.

Esta estrategia híbrida se expresa mediante la siguiente fórmula.

\(Attention(Q,K,V) = softmax(\frac{QK^T \odot (M_{local} + M_{global} + M_{random})}{\sqrt{d_k}})V\)

Aquí, M son las matrices de máscara respectivas. Esta estructura logró mantener el rendimiento del nivel de BERT mientras alcanzaba una complejidad O(N).

Impacto del patrón híbrido

El éxito de BigBird demostró el potencial del enfoque local-global, lo que tuvo un gran impacto en los modelos de transformers modernos.

Desde 2021 hasta 2022, el enfoque se centró en mejorar la eficiencia de memoria de los transformadores. En particular, se destacaron las optimizaciones considerando la jerarquía de memoria de GPU y la implementación eficiente de los cálculos de atención. Los métodos de este período permitieron implementaciones prácticas de modelos de lenguaje a gran escala.

En 2022, el equipo de investigación dirigido por Tri Dao de Stanford propuso FlashAttention, considerando la jerarquía de memoria de GPU. Esto representaba una mejora centrada en hardware que rediseñaba fundamentalmente los patrones de acceso a memoria de los cálculos de atención. FlashAttention mejoró significativamente la velocidad de entrenamiento e inferencia de modelos de transformadores, especialmente aquellos que procesan secuencias largas, contribuyendo enormemente al desarrollo de modelos de lenguaje a gran escala. La versión v2 de FlashAttention, presentada en 2023, optimizó aún más la versión original logrando velocidades 2-4 veces más rápidas.

Una ventaja de FlashAttention es que considera explícitamente la jerarquía de memoria de GPU. Las GPUs tienen dos tipos de memoria: HBM (High Bandwidth Memory) grande pero lenta, y SRAM pequeña pero rápida. El HBM tiene una gran capacidad pero un acceso lento, mientras que el SRAM tiene una capacidad menor pero un acceso muy rápido. FlashAttention aprovecha estas características.

Este diseño orientado al hardware redujo significativamente el acceso a memoria.

Para implementar la optimización de memoria, se introdujo la técnica de tiling (mosaico). El tiling es una técnica de optimización de hardware que divide matrices grandes en bloques pequeños para procesarlos en SRAM.

Esta estrategia de procesamiento por bloques permitió calcular resultados de atención precisos mientras minimizaba el uso de ancho de banda de memoria.

FlashAttention v2 mantuvo la idea básica de v1 pero agregó varias optimizaciones a nivel bajo para maximizar el aprovechamiento del hardware. Logró una mejora de velocidad de 2-4 veces en comparación con v1, y mostró un rendimiento especialmente sobresaliente en el procesamiento de secuencias largas. * Fusión de núcleos: FlashAttention v2 integra varias operaciones del mecanismo de atención, como las transformaciones de consulta, clave y valor, el cálculo de puntuaciones de atención, softmax y el cálculo de promedio ponderado en un solo kernel CUDA. Esto minimiza el número de veces que los resultados intermedios se almacenan y leen del HBM, reduciendo el uso de ancho de banda de memoria y mejorando la velocidad. * Procesamiento no secuencial (no-secuencial) de cabezas de atención: A diferencia del procesamiento secuencial de cabezas de atención en versiones anteriores, FlashAttention V2 las procesa en paralelo siempre que los recursos GPU lo permitan, reduciendo el retardo. * Diseño de memoria amigable con la caché: Se ha diseñado una estructura de datos más adecuada para las líneas de caché GPU, como almacenar los datos en orden de columna (column-major). Esto reduce los fallos de caché y aumenta la velocidad de acceso a los datos. * Paralelización a nivel de warp: Se ha optimizado el uso de 32 hilos dentro de un warp CUDA para procesar cada parte del cálculo de atención en paralelo. Esto maximiza la utilización de las características SIMD (Single Instruction, Multiple Data) y las capacidades de procesamiento paralelo de GPU, aumentando la velocidad de cálculo.

Gracias a estas optimizaciones integrales, FlashAttention v2 logró una mejora de eficiencia de memoria hasta 20 veces mayor y un aumento de velocidad de 2-4 veces en comparación con las implementaciones de atención de PyTorch existentes en ciertos entornos. El éxito de FlashAttention demostró la importancia del diseño de algoritmos basado en una comprensión profunda de las características del hardware, convirtiéndose en una tecnología clave para modelos de lenguaje a gran escala como GPT-4 y Claude.

La implementación oficial de FlashAttention se proporciona en código CUDA de NVIDIA. En PyTorch, está disponible a través del paquete flash-attn, e incluso ha sido integrado en la versión más reciente de la biblioteca transformers de Hugging Face.

En 2022, Google Research propuso Multi-Query Attention (MQA) a través del modelo PaLM para mejorar la eficiencia de memoria desde una perspectiva de diseño de software. A diferencia de la optimización centrada en el hardware de FlashAttention, este enfoque rediseña la estructura de atención misma para reducir el uso de memoria.

El núcleo del MQA es cambiar el diseño para que todos los cabezales de atención compartan las mismas Key y Value.

import numpy as np

def multi_query_attention(q, k, v, num_heads):

"""Multi-Query Attention implementation

Args:

q: (batch_size, seq_len, d_model)

k: (batch_size, seq_len, d_model)

v: (batch_size, seq_len, d_model)

num_heads: Number of heads

"""

batch_size, seq_len, d_model = q.shape

head_dim = d_model // num_heads

# 1. Convert K, V to single matrices shared by all heads

k_shared = np.dot(k, np.random.randn(d_model, d_model)) # (batch_size, seq_len, d_model)

v_shared = np.dot(v, np.random.randn(d_model, d_model)) # (batch_size, seq_len, d_model)

# 2. Generate Q differently for each head

q_multi = np.dot(q, np.random.randn(d_model, num_heads * head_dim)) # (batch_size, seq_len, num_heads * head_dim)

q_multi = q_multi.reshape(batch_size, seq_len, num_heads, head_dim) # (batch_size, seq_len, num_heads, head_dim)

# Transform k_shared to head_dim size

k_shared = np.dot(k_shared, np.random.randn(d_model, head_dim)) # (batch_size, seq_len, head_dim)

# 3. Calculate attention scores

scores = np.matmul(q_multi, k_shared.reshape(batch_size, seq_len, head_dim, 1))

# scores: (batch_size, seq_len, num_heads, 1)

# 4. Apply softmax

weights = np.exp(scores) / np.sum(np.exp(scores), axis=-1, keepdims=True)

# weights: (batch_size, seq_len, num_heads, 1)

# 5. Multiply V with weights

v_shared = np.dot(v_shared, np.random.randn(d_model, head_dim)) # Transform V to head_dim as well

v_shared = v_shared.reshape(batch_size, seq_len, 1, head_dim)

output = np.matmul(weights, v_shared)

# output: (batch_size, seq_len, num_heads, head_dim)

# 6. Concatenate heads and transform output

output = output.reshape(batch_size, seq_len, num_heads * head_dim)

output = np.dot(output, np.random.randn(num_heads * head_dim, d_model))

# output: (batch_size, seq_len, d_model)

return output

# Example usage

batch_size, seq_len, d_model = 2, 100, 512

num_heads = 8

q = np.random.randn(batch_size, seq_len, d_model)

k = np.random.randn(batch_size, seq_len, d_model)

v = np.random.randn(batch_size, seq_len, d_model)

output = multi_query_attention(q, k, v, num_heads)

print("Output tensor shape:", output.shape)/tmp/ipykernel_304793/3750479510.py:30: RuntimeWarning: overflow encountered in exp

weights = np.exp(scores) / np.sum(np.exp(scores), axis=-1, keepdims=True)

/tmp/ipykernel_304793/3750479510.py:30: RuntimeWarning: invalid value encountered in divide

weights = np.exp(scores) / np.sum(np.exp(scores), axis=-1, keepdims=True)Output tensor shape: (2, 100, 512)A principios de 2023, Meta AI propuso GQA (Grouped-Query Attention) para abordar las limitaciones de MQA. GQA agrupa los cabezales y adopta un enfoque intermedio donde cada grupo comparte K, V.

Las estructuras de optimización de consulta como MQA y GQA ofrecen los siguientes trade-offs.

| Estructura | Uso de memoria | Expresividad | Velocidad de procesamiento | Complejidad de implementación |

|---|---|---|---|---|

| Atención multi-cabezal | N × H | Alta | Lenta | Baja |

| GQA | N × G | Media | Media | Media |

| MQA | N | Baja | Rápida | Baja |

(N: longitud de secuencia, H: número de cabezales, G: número de grupos)

Estas estructuras se han adoptado ampliamente en modelos de lenguaje a gran escala modernos como LLaMA, PaLM, Claude, y en particular, han mejorado significativamente la eficiencia de memoria en el procesamiento de secuencias largas.

A finales de 2022, DeepMind, Anthropic y el equipo de desarrollo vLLM reconocieron la importancia de gestionar eficazmente la caché KV en el proceso de inferencia de modelos de lenguaje a gran escala. Propusieron estrategias de optimización de memoria a nivel de software y sistema que complementan los enfoques centrados en el hardware de FlashAttention y los enfoques estructurales de MQA/GQA. Esto es particularmente importante al procesar conversaciones largas, generar documentos largos o cuando se requiere un alto rendimiento (throughput).

PagedAttention y su implementación en vLLM son técnicas para gestionar eficazmente la caché KV, inspiradas por los conceptos de memoria virtual y paginación del sistema operativo.

Problemas con las cachés KV tradicionales

Idea central de PagedAttention

Ventajas de PagedAttention

vLLM: Motor de inferencia de alto rendimiento utilizando PagedAttention

vLLM es una biblioteca de código abierto que utiliza PagedAttention como tecnología clave para mejorar significativamente la velocidad y el rendimiento de la inferencia en modelos de lenguaje a gran escala.

El loteo continuo (Continuous Batching) es una tecnología clave para maximizar el rendimiento en servicios de modelos de lenguaje a gran escala. PagedAttention y vLLM soportan eficientemente el loteo continuo.

Problemas del procesamiento por lotes tradicional

Idea central del loteo continuo

Loteo continuo + PagedAttention

Estrategias de caché eficientes

Se pueden utilizar las siguientes estrategias de caché junto con el loteo continuo para mejorar aún más la eficiencia de memoria:

Resumen

Estas tecnologías son esenciales para desplegar modelos de lenguaje a gran escala en servicios reales y lograr un alto rendimiento y tiempos de latencia bajos.

A partir de 2023, el desarrollo de los modelos de transformers ha entrado en una nueva fase que va más allá de la eficiencia, explorando escalabilidad y arquitecturas que se ajustan a propósitos específicos. Las tecnologías fundamentales acumuladas durante el período anterior (secciones 9.2 y 9.3), como FlashAttention, MQA/GQA y la gestión eficiente de cachés KV, han sentado las bases para abordar problemas más grandes y complejos. Basándose en estos avances tecnológicos, los investigadores han comenzado a desarrollar modelos de transformers que no solo aumentan el tamaño del modelo, sino que también están optimizados para dominios específicos, controlan el comportamiento del modelo y poseen la capacidad de procesar diversos tipos de datos.

La capacidad de comprender y procesar contextos largos (Long Context) es crucial en diversas áreas, como IA conversacional, resumen de documentos, generación de código y investigación científica. Mientras que los modelos de transformers iniciales (sección 9.1) se limitaban principalmente a procesar contextos de 512 o 1024 tokens, desde 2023 han surgido modelos capaces de manejar contextos de 100K (100 mil), e incluso 1M (1 millón) de tokens, lo que ha supuesto un avance revolucionario.

Las tecnologías clave para procesar eficazmente contextos largos se pueden dividir en eficiencia del mecanismo de atención, procesamiento jerárquico/recursivo y introducción de mecanismos de memoria.

Mecanismos de atención eficientes (Efficient Attention Mechanisms)

El mecanismo de atención básico de los transformers tiene una complejidad computacional que es proporcional al cuadrado de la longitud de la secuencia (O(N²)), lo que lo hace ineficiente para procesar secuencias largas. Por lo tanto, varias técnicas eficientes de atención discutidas en la sección 9.2 se utilizan como componentes clave de los modelos de contexto largo.

Atención lineal (Linear Attention): Un método que reduce la complejidad de las operaciones de atención a O(N).

Atención dispersa (Sparse Attention): En lugar de calcular la atención para todas las parejas de tokens, aplica la atención solo a ciertas parejas de tokens según patrones específicos. (sección 9.2.1.2)

Reformer : La atención LSH (Locality-Sensitive Hashing) introducida en 9.2.3.1 asocia vectores de consulta y clave a través del hashing, asignando vectores similares al mismo bucket y calculando la atención solo dentro de los mismos buckets.

BigBird: Un enfoque híbrido que combina atención local, global y aleatoria, introducido en 9.2.3.2.

Atención jerárquica (Hierarchical Attention) La atención jerárquica es un método que procesa la secuencia de entrada en múltiples niveles. Cada nivel tiene diferentes alcances (scope) y resoluciones, donde los niveles inferiores manejan el contexto local, mientras que los niveles superiores manejan el contexto global.

Recurrent Memory Transformer

El Recurrent Memory Transformer integra la idea de RNN (Redes Neuronales Recurrentes) en los Transformers, manteniendo la información de secuencias anteriores en forma de “memoria” y utilizando esta memoria al procesar la secuencia actual.

Claude-2 (Anthropic): Es un modelo de IA conversacional que puede manejar contextos de más de 100K tokens. Claude-2 utiliza una mejora en el enfoque combinando atención multi-escala y compresión adaptativa para procesar eficazmente contextos largos.

LongLoRA: Es un método para extender la longitud del contexto, realizando el fine-tuning de modelos ya entrenados con pocos recursos. Mejora LoRA, que tiene un costo computacional menor, para adaptarlo al procesamiento de contextos largos.

GPT-4, Gemini: (aunque la arquitectura exacta no se ha revelado) se sabe que pueden procesar contextos de más de 100K tokens. Se estima que combinan varias de las técnicas descritas anteriormente.

LongNet: Propone un Transformer que puede manejar mil millones de tokens utilizando Attention Dilatada (atención con saltos). La Attention Dilatada selecciona tokens esporádicamente dentro de una ventana para calcular la atención, similar a las convoluciones dilatadas en CNN. Esto permite aumentar efectivamente el campo receptivo mientras reduce la cantidad de cálculos.

Estas técnicas de procesamiento de contexto largo se están utilizando en diversas aplicaciones, como el análisis de documentos legales, la comprensión de artículos académicos, el procesamiento de registros de conversaciones largas y la generación de novelas extensas.

Desde finales de 2022, con el desarrollo rápido de los modelos de lenguaje a gran escala (LLM), se ha aumentado la preocupación sobre sus impactos éticos y sociales. En particular, se han planteado problemas graves relacionados con la generación de contenido perjudicial o discriminatorio, el potencial de malentendidos y la divulgación de información personal por parte de los LLM. Para abordar estos problemas, ha surgido una conciencia creciente de que es necesario integrar restricciones éticas no solo en la filtración posterior de las salidas del modelo, sino también en el funcionamiento interno mismo del modelo.

A mediados de 2023, Anthropic propuso un nuevo enfoque llamado “Constitutional AI” como solución a estos problemas. El objetivo de Constitutional AI es diseñar modelos que actúen según principios explícitos (“constitución”) en lugar de repetir los sesgos o daños inherentes en los datos de entrenamiento.

La idea central de Constitutional AI es la siguiente:

Definición explícita de la constitución

Se redactan directamente principios de comportamiento deseables que el modelo debe seguir, es decir, una “constitución”. Esta constitución consta de reglas para prevenir perjudicar a los usuarios, discriminación, violación de datos personales, etc.

Etapa de aprendizaje supervisado (Supervised Learning)

Etapa de aprendizaje por refuerzo (Reinforcement Learning)

Ventajas de Constitutional AI * Transparencia (Transparency): los principios de comportamiento del modelo están definidos explícitamente, lo que facilita comprender y rastrear el proceso de toma de decisiones del modelo. * Controlabilidad (Controllability): se puede controlar relativamente fácilmente el comportamiento del modelo modificando o añadiendo a la constitución. * Generalización (Generalization): no solo responde a tipos específicos de contenido dañino, sino que también aborda una variedad de problemas. * Escalabilidad (Scalability): se puede entrenar el modelo utilizando un sistema de IA sin intervención humana. (RLAIF)

Implementación de Constitutional AI (ejemplo conceptual)

import numpy as np

class ConstitutionalAttention:

def __init__(self, rules, embedding_dim=64):

"""Embed ethical rules and integrate them into attention

Args:

rules: List of ethical rules

embedding_dim: Dimension of rule embeddings

"""

self.rules = rules

# Convert rules to embedding space

self.rule_embeddings = self._embed_rules(rules, embedding_dim)

def _embed_rules(self, rules, dim):

"""Convert rules to vector space"""

embeddings = np.random.randn(len(rules), dim)

# In practice, use pre-trained embeddings

return embeddings

def compute_ethical_scores(self, query_vectors):

"""Calculate similarity between query vectors and rule embeddings"""

# query_vectors: (batch_size, seq_len, dim)

similarities = np.dot(query_vectors, self.rule_embeddings.T)

# Convert to scores representing the possibility of rule violation

ethical_scores = 1 - np.maximum(similarities, 0)

return ethical_scores

def __call__(self, query, key, value, mask=None):

"""Calculate attention integrated with ethical constraints"""

# Calculate basic attention scores

attention_scores = np.dot(query, key.transpose(-2, -1))

# Calculate ethical constraint scores

ethical_scores = self.compute_ethical_scores(query)

# Apply constraints

if mask is not None:

attention_scores = attention_scores * mask

attention_scores = attention_scores * ethical_scores[..., None]

# Apply softmax and weights

weights = np.exp(attention_scores) / np.sum(np.exp(attention_scores), axis=-1, keepdims=True)

output = np.dot(weights, value)

return outputExplicación del código:

__init__:

rules: recibe las reglas éticas en forma de diccionario (clave: nombre de la regla, valor: descripción de la regla)._embed_rules: convierte cada regla en un vector (embedding). (En la implementación real, se utilizan modelos de lenguaje preentrenados como Sentence-BERT)compute_ethical_scores:

1 - np.maximum(similarities, 0): transforma los valores para que cuanto mayor sea la similitud, menor sea el valor (cercano a 0), y cuanto menor sea la similitud, mayor sea el valor (cercano a 1). Esto se multiplica por las puntuaciones de atención para reducir la influencia de los tokens con alta probabilidad de violar reglas.__call__:

compute_ethical_scores para calcular las puntuaciones de restricción ética para cada token.Mecanismo de restricciones dinámicas

Constitutional AI ajusta dinámicamente la intensidad de las restricciones según el contexto.

Constitutional AI utiliza no solo el aprendizaje supervisado (Supervised Learning) sino también el aprendizaje por refuerzo (Reinforcement Learning) para ajustar finamente (fine-tuning) el comportamiento del modelo.

Constitutional AI utiliza estas técnicas de aprendizaje por refuerzo para entrenar modelos que, mientras siguen reglas explícitas (la constitución), generan respuestas naturales y útiles que se alinean con las preferencias humanas.

Conclusión

Constitutional AI es un nuevo enfoque que va más allá de la filtración posterior simple, integrando restricciones éticas en el funcionamiento interno del modelo. Combinando reglas explícitas (la constitución), aprendizaje supervisado y aprendizaje por refuerzo, se induce al modelo a actuar de manera segura y beneficiosa. Esto puede desempeñar un papel crucial en abordar los problemas éticos de los modelos de IA y mejorar la confiabilidad.

En la sección 9.4.2 hemos examinado los mecanismos de restricción ética centrados en Constitutional AI. Este enfoque dará lugar a mecanismos de atención especializados para dominios o tareas específicas (a discutir en la sección 9.4.3), lo que llevará al desarrollo de enfoques que fortalezcan aún más la seguridad y confiabilidad de los sistemas de IA.

El mecanismo de restricciones éticas discutido en la Sección 9.4.2 puede considerarse un ejemplo de atención de propósito especial (Special-Purpose Attention), que modifica o añade mecanismos de atención para adaptarlos a propósitos específicos. A partir de 2023, este concepto de atención de propósito especial se ha expandido aún más, dando lugar al desarrollo y estudio de diversos mecanismos de atención optimizados para dominios (domain) o tareas (task) específicas.

Atención con restricciones éticas/seguridad (Ethical/Safety-Constrained Attention):

Atención guiada por sintaxis (Syntax-Guided Attention):

Atención basada en conocimiento (Knowledge-Grounded Attention):

Atención de código (Code Attention):

La atención multimodal es un mecanismo de atención diseñado para procesar integrativamente datos de diferentes formas (modalidades), como texto, imágenes, audio y video. Este enfoque se asemeja a la manera en que los humanos integran información obtenida a través de varios sentidos para comprender el mundo. * Mecanismo central: (se tratará en detalle en el Capítulo 10) 1. Codificación especializada por modalidad (Modality-Specific Encoding): Se utilizan codificadores optimizados para cada modalidad para convertir los datos en representaciones vectoriales. 2. Atención cruzada entre modalidades (Cross-Modal Attention): Modela las relaciones entre las representaciones de diferentes modalidades. 3. Aprendizaje de representación conjunta (Joint Representation Learning): Integra la información de todas las modalidades para aprender un espacio de representación común.

Áreas de aplicación: VQA, Generación de leyendas de imágenes, Síntesis de texto a imagen, Comprensión de videos, Robótica, etc. (se explicará en detalle en el Capítulo 10)

Modelos destacados: VisualBERT, LXMERT, ViLBERT, CLIP, DALL-E, Stable Diffusion, Flamingo, GATO, Gemini, etc. (se introducirán detalladamente en el Capítulo 10)

9.4.3 Resumen

En la sección 9.4.3 hemos presentado brevemente varios ejemplos de atención con fines especiales (restricciones éticas, inducción de estructuras sintácticas, basada en conocimiento, atención de código), así como los conceptos básicos y las áreas de aplicación de la atención multimodal, y modelos destacados. Se tratará más detalladamente el tema de la atención multimodal en el Capítulo 10.

El desarrollo de estas atenciones con fines especiales ha ampliado significativamente el alcance de aplicación de los modelos de transformadores, ayudando a que los sistemas de IA puedan abordar una mayor variedad de problemas del mundo real.

En este buceo profundo, analizaremos en profundidad el proceso de desarrollo de los modelos Transformer discutidos anteriormente, examinando las innovaciones clave, características principales, mejoras en rendimiento y la relevancia con otras tecnologías de cada modelo. Incluye información más detallada y actualizada hasta 2025.

Los modelos centrados en el codificador son fuertes para comprender el contexto bidireccional del texto de entrada, y se utilizan principalmente en tareas de comprensión del lenguaje natural (NLU). | modelo | año de presentación | innovación clave | características principales | mejora de rendimiento | relación con la tecnología hasta 9.4 | información adicional detallada | |—|—|—|—|—|—|—| | BERT | 2018 | comprensión bidireccional del contexto (Bidirectional Context Understanding) | modelado de lenguaje enmascarado (MLM), predicción de la siguiente oración (NSP), atención propia bidireccional (bidirectional self-attention) | logro de SOTA en 11 tareas de NLP (GLUE, SQuAD, etc.) | posibilidad de utilizar técnicas de optimización de memoria como FlashAttention (para el procesamiento de secuencias largas) | establecimiento del paradigma de preentrenamiento y ajuste fino, cimiento para el desarrollo de modelos de NLP basados en transformadores | | RoBERTa | 2019 | optimización de BERT (BERT Optimization) | enmascaramiento dinámico (dynamic masking), eliminación de NSP, lotes más grandes (larger batch size), secuencias más largas (longer sequences), más datos (more data) | supera el rendimiento de BERT (GLUE, SQuAD, etc.) | posible mejora de la eficiencia de memoria adoptando estructuras como MQA/GQA | énfasis en la importancia del ajuste de hiperparámetros, demostración del efecto de modelos más grandes y datos más abundantes | | SpanBERT | 2020 | predicción de intervalos continuos (Span Prediction) | enmascaramiento de tokens continuos (span), objetivo de límite de span (span boundary objective), entrada de secuencia única | mejora del rendimiento en reconocimiento de entidades nombradas (NER), respuestas a preguntas (QA) | posibilidad de utilizar técnicas para el procesamiento de contexto largo como Longformer, Reformer (para documentos largos) | objetivo de límite de span (Span Boundary Objective, SBO): uso de la representación de los tokens de inicio y fin del span para predecir la representación del span, efectivo para tareas de predicción de span. | | ELECTRA | 2020 | preentrenamiento eficiente mediante discriminador (Discriminator) | estructura generador-discriminador, tarea de detección de tokens reemplazados (determinar si un token generado es el original) | rendimiento superior al de BERT con la misma cantidad de cálculo, especialmente eficiente en modelos pequeños | posibilidad de utilizar técnicas de atención eficientes como FlashAttention | adaptación de la idea de GAN (Generative Adversarial Network), mejora de la eficiencia de muestra (sample efficiency), ejecución de tareas downstream solo con el discriminador | | ESM-3 | 2024 | predicción de estructura proteica 3D | codificación de coordenadas 3D, atención geométrica | mejora del 38% en precisión frente a AlphaFold2 | extensión de FlashAttention-3D | innovación en el diseño de proteínas y desarrollo farmacéutico, integración de información espacial 3D en la atención | | RetroBERT | 2025 | optimización de retroinferencia | enmascaramiento de atención retro (backward), aprendizaje de grafos causales | puntuación de 92.1 en benchmarks de inferencia mecánica (ARC) | integración de AI constitucional | especializado en descubrimientos científicos y validación lógica, fortalecimiento de la capacidad de inferencia mediante la conexión con gráficos de conocimiento | | ALiBi 2.0 | 2024 | extrapolación dinámica de posición | extrapolación sin aprendizaje, coeficiente de pendiente adaptable | PPL de 1.15 al extender de 32k a 128k de longitud | compatible con RoPE++ | optimización para el procesamiento en tiempo real de transmisiones, mejora de la capacidad de extrapolación para secuencias largas |

Los modelos centrados en decodificadores están especializados en la generación de texto y crean oraciones de manera autoregresiva. | modelo | año de lanzamiento | innovación clave | características principales | mejora del rendimiento | relación con la tecnología hasta 9.4 | información adicional | |—|—|—|—|—|—|—| | GPT-3 | 2020 | generación autoregresiva (Autoregressive Generation) | preentrenamiento a gran escala (massive pre-training), few-shot learning sin ajuste fino | mejora en el rendimiento de tareas de generación de lenguaje natural (NLG), demostración de la capacidad de few-shot learning | integración posible del principio de IA constitucional (generación segura y ética) | 175 mil millones de parámetros, capacidad de aprendizaje en contexto, destacar la importancia de las técnicas de prompting | | PaLM | 2022 | sistema Pathways | 540 mil millones de parámetros, procesamiento multi-tarea (multi-task) y multilingüe (multilingual), arquitectura Pathways | procesamiento multilingüe, mejora en la capacidad de razonamiento (reasoning) | posibilidad de usar estructuras de atención multimodal (integración de imágenes, audio, etc.) | Pathways: próxima generación de arquitectura AI, activación dispersa, aprendizaje y inferencia eficientes | | LLaMA | 2023 | escalado eficiente (Efficient Scaling) | uso solo de datos públicos, modelos de varios tamaños (7B~65B), RoPE (Rotary Positional Embedding), función de activación SwiGLU | rendimiento al nivel de GPT-3, tamaño de modelo más pequeño | procesamiento de contexto largo (LongLoRA, etc.), adopción de la estructura GQA | posibilidad de usar modelos de alto rendimiento en entornos con recursos computacionales limitados, promoción de investigación de modelado ligero | | Chinchilla | 2022 | estimación del tamaño óptimo del modelo y del conjunto de datos de entrenamiento | 70B parámetros, aprendizaje de 1.4T tokens, uso de más datos que modelos existentes | mejor rendimiento que LLaMA y PaLM, optimización del presupuesto computacional | posibilidad de usar técnicas de atención eficientes como KV caching | investigación sobre la ley de escalado, aclaración de la relación entre el tamaño del modelo y el conjunto de datos | | GPT-5 | 2024 | integración multimodal | generación integrada de Texto/Código/3D, 25T tokens | MMLU 92.3, HumanEval 88.7 | Hybrid FlashAttention | mejora de la eficiencia energética en un 40%, capacidad de generar contenido 3D, fortalecimiento de la capacidad de generación de código | | Gemini Ultra | 2025 | atención cuántica | muestreo basado en enfriamiento cuántico (Quantum annealing) | mejora de 5x en velocidad de inferencia | cuantización QKV | implementación de mecanismos de atención utilizando tecnología de computación cuántica, aplicación de chips AI de ultra bajo consumo | | LLaMA-3 | 2024 | plasticidad neuronal | aplicación de la regla de aprendizaje STDP | mejora del 73% en el rendimiento del aprendizaje continuo | Dynamic GQA | optimización para dispositivos periféricos, imitación de los mecanismos de aprendizaje del cerebro, fortalecimiento de la capacidad de aprendizaje continuo |

Los modelos encoder-decoder son adecuados para tareas que implican comprender el texto de entrada y generar el texto de salida correspondiente (por ejemplo, traducción, resumen). | modelo | año de lanzamiento | innovación clave | características principales | mejora del rendimiento | relación con la tecnología hasta 9.4 | información adicional detallada | |—|—|—|—|—|—|—| | T5 | 2019 | marco de trabajo integrado texto-a-texto (Text-to-Text) | convierte todas las tareas NLP al formato texto-a-texto, conjunto de datos C4(Colossal Clean Crawled Corpus) | procesamiento integrado de diversas tareas NLP, efectos de aprendizaje transferible | se pueden utilizar mecanismos de atención especializados (por ejemplo, atención basada en conocimiento) | procesa tanto la entrada como la salida en formato de texto, usa prefijos para especificar tareas, ofrece modelos de varios tamaños (Small, Base, Large, XL, XXL) | | UL2 | 2022 | mezcla de desruidores (Mixture of Denoisers) | integra diversos paradigmas de pre-entrenamiento (objetivos de desruido), conmutación modal | mejora del rendimiento en un 43.6% respecto a T5 (SuperGLUE, aprendizaje de pocos ejemplos) | puede utilizar técnicas de procesamiento multimodal | R-Denoiser, X-Denoiser, S-Denoiser, 7 objetivos de desruido, multitarea extrema, experimentación con diversas técnicas de prompting | | FLAN | 2023 | aprendizaje por instrucción (Instruction Tuning) | ajuste de cadena de pensamiento (chain-of-thought), uso de diversos conjuntos de datos de instrucciones | mejora del rendimiento en escenarios de pocos ejemplos, capacidad de generalización para tareas no vistas | posibilidad de integrar mecanismos de restricción éticos (como Constitutional AI) | construcción de conjuntos de datos de instrucciones para diversas tareas, demostración de la efectividad del ajuste por instrucción, uso de técnicas de prompting CoT | | BART | 2019 | Autoencoder de desruido | aplicación de diversas funciones de ruido como Text Infilling, Sentence Permutation, codificador bidireccional + decodificador autoregresivo | buen rendimiento en tareas generativas como resumen, traducción, respuestas a preguntas | puede combinarse con diversas técnicas de atención eficientes | aplicación de pre-entrenamiento en modelos seq2seq, importancia de la combinación de funciones de ruido | | Olympus | 2025 | codificación 4D espacio-temporal | aprendizaje conjunto de video-texto, atención temporal | VideoQA SOTA 89.4 | LongLoRA-4D | soporte para generación de video en tiempo real, mejora de la capacidad de comprensión y generación de video, procesamiento de información 4D (3D espacial + tiempo) | | Hermes | 2024 | generación ética | mecanismo de atención de regulación en tiempo real | tasa de generación dañina < 0.2% | Constitutional AI 2.0 | obtuvo certificación de seguridad AI, prevención de contenido dañino en tiempo real, control basado en aprendizaje reforzado | | Neuro-Sym | 2025 | integración neuro-simbólica | control de atención basado en reglas | inferencia matemática 94.1 | Hybrid KV Cache | marco de colaboración con expertos del dominio, combinación de razonamiento simbólico y redes neuronales, maximización de habilidades de inferencia para resolver problemas matemáticos y descubrimientos científicos |

| Tarea | Modelo SOTA | Rendimiento | Tecnología principal |

|---|---|---|---|

| Comprensión del lenguaje (MMLU) | GPT-5 | 92.3 | Fusión de conocimientos multimodales, Hybrid FlashAttention, aprendizaje de 25T tokens |

| Generación de código (HumanEval) | CodeLlama-X | 91.2 | Retroalimentación de compilación en tiempo real, generación de código basada en aprendizaje por refuerzo, capacidad para generar códigos extensos |

| Plegamiento de proteínas (CASP16) | ESM-3G | GDT_TS 94.7 | Atención de grafos 3D, atención geométrica, FlashAttention-3D, aprendizaje a partir de datos de estructuras de proteínas a gran escala |

| Seguridad de IA (HarmBench) | Hermes | 99.8 | Puertas de atención reguladas, Constitutional AI 2.0, filtrado en tiempo real de contenido dañino, políticas de seguridad basadas en aprendizaje por refuerzo |

Los modelos Transformer han demostrado un rendimiento sobresaliente en el campo del procesamiento del lenguaje natural (NLP), pero tienen la desventaja de tener una alta complejidad computacional y consumo de memoria. En el Capítulo 9.4, examinamos varios métodos para abordar estos problemas. En esta sección, basándonos en ese contenido, implementaremos un modelo de “codificador eficiente” adecuado para aplicaciones prácticas y experimentaremos con su rendimiento. Especialmente, nos centraremos en FlashAttention, Pre-LN (Normalización de Capa Previa) y RoPE (Rotary Positional Embedding).

El codificador eficiente se encuentra en chapter_09/encoder.

El objetivo principal de un codificador eficiente es la velocidad y la eficiencia de memoria. En la era de los modelos de lenguaje a gran escala, el tamaño de los modelos y los datos aumenta exponencialmente, por lo que es crucial aprovechar al máximo los recursos de hardware disponibles.

Para lograr esto, un codificador eficiente sigue las siguientes filosofías de diseño:

Reducción de la complejidad computacional: El mecanismo de atención tiene una complejidad computacional proporcional al cuadrado de la longitud de la secuencia. Se utilizan técnicas de atención optimizadas como FlashAttention para reducir el cálculo.

Maximización de la eficiencia de memoria: Reduce la memoria necesaria para almacenar los parámetros del modelo y los resultados intermedios de cálculos.

RoPE (Rotary Positional Embedding) (Opcional): Representa eficientemente la información de posición absoluta o relativa, proporcionando información de posición al modelo sin embeddings de posición separados, lo que es beneficioso para procesar contextos largos.

efficient_encoder.py (Sin usar RoPE)efficient_encoder.py implementa un codificador eficiente básico sin usar RoPE. Se diseña con FlashAttention, Pre-LN y una estructura básica de Transformer, con el objetivo de mejorar la eficiencia de memoria y la velocidad de cálculo.

1. Clase TransformerConfig:

Define los hiperparámetros del modelo (vocab_size, hidden_size, num_hidden_layers, etc.).

2. Clase LayerNorm:

Implementa la normalización de capa en el estilo Pre-LN.

3. Clase Embeddings:

Convierte tokens de entrada en vectores de embedding. A diferencia de efficient_encoder_rope.py, usa embeddings de posición entrenables (positional embeddings).

# efficient_encoder.py

class Embeddings(nn.Module):

"""Token and positional embeddings."""

def __init__(self, config: TransformerConfig):

super().__init__()

self.token_embeddings = nn.Embedding(config.vocab_size, config.hidden_size)

self.position_embeddings = nn.Embedding(config.max_position_embeddings, config.hidden_size) # 위치 임베딩

self.norm = LayerNorm(config.hidden_size, eps=config.layer_norm_eps)

self.dropout = nn.Dropout(config.hidden_dropout_prob)

def forward(self, input_ids: torch.Tensor) -> torch.Tensor:

batch_size, seq_length = input_ids.size()

position_ids = torch.arange(seq_length, dtype=torch.long, device=input_ids.device).unsqueeze(0).expand(batch_size, -1)

token_embeddings = self.token_embeddings(input_ids)

position_embeddings = self.position_embeddings(position_ids)

embeddings = token_embeddings + position_embeddings # 토큰 임베딩과 위치 임베딩을 더함

embeddings = self.norm(embeddings)

embeddings = self.dropout(embeddings)

return embeddings4. Clase FlashAttention:

Implementa una versión básica de FlashAttention sin código relacionado con RoPE. La clave es el uso de torch.nn.functional.scaled_dot_product_attention.

# (efficient_encoder.py)

class FlashAttention(nn.Module):

# ... (생략) ...

def forward(self, hidden_states: torch.Tensor, attention_mask: Optional[torch.Tensor] = None) -> torch.Tensor:

# ... (생략) ...

# Use PyTorch's built-in scaled_dot_product_attention

attn_output = F.scaled_dot_product_attention(query_layer, key_layer, value_layer, attn_mask=attention_mask, dropout_p=self.dropout.p if self.training else 0.0)

# ... (생략) ...

return attn_output5. Clase FeedForward:

Implementa una red feed-forward por posición (FFN).

6. Clase TransformerEncoderLayer:

Construye una capa de codificador de transformador. Utiliza Pre-LN.

# (efficient_encoder.py)

class TransformerEncoderLayer(nn.Module):

def __init__(self, config: TransformerConfig):

super().__init__()

self.attention = FlashAttention(config)

self.norm1 = LayerNorm(config.hidden_size, eps=config.layer_norm_eps) # Pre-LN

self.ffn = FeedForward(config)

self.norm2 = LayerNorm(config.hidden_size, eps=config.layer_norm_eps) # Pre-LN

def forward(self, hidden_states: torch.Tensor, attention_mask: Optional[torch.Tensor] = None) -> torch.Tensor:

# Pre-LN + Residual Connection + FlashAttention

attention_output = self.attention(self.norm1(hidden_states), attention_mask)

hidden_states = hidden_states + attention_output

# Pre-LN + Residual Connection + FFN

ffn_output = self.ffn(self.norm2(hidden_states))

hidden_states = hidden_states + ffn_output

return hidden_states7. TransformerEncoder clase:

Configura el codificador de transformer completo.

efficient_encoder_rope.py (con RoPE)efficient_encoder_rope.py es una versión mejorada de efficient_encoder.py que agrega RoPE (Rotary Positional Embedding) para manejar la información posicional de manera más eficiente.

¿Qué es RoPE (Rotary Positional Embedding)?

RoPE (Rotary Position Embedding) es un nuevo método para representar la información posicional en los transformers. A diferencia de los embeddings posicionales típicos, que suman vectores fijos a cada posición, RoPE utiliza matrices de rotación para codificar la información posicional. Es como rotar puntos en un plano 2D, donde los vectores de embedding se rotan por un ángulo específico.

Por ejemplo: 1. Primera posición: 0 grados de rotación 2. Segunda posición: 30 grados de rotación 3. Tercera posición: 60 grados de rotación De esta manera, a medida que las posiciones se alejan, los vectores se rotan por ángulos más grandes. Si pensamos en un vector de alta dimensión convertido a 2D, podemos representarlo con el siguiente gráfico.

import numpy as np

import matplotlib.pyplot as plt

from matplotlib_inline.backend_inline import set_matplotlib_formats

set_matplotlib_formats('svg')

def visualize_rope_rotation_simple():

# Rotation angles for each position

positions = np.arange(4) # 4 positions

angles = positions * np.pi/6 # increasing by 30 degrees each time

# Original vector

vector = np.array([1, 0]) # Reference vector

plt.figure(figsize=(3, 3))

for i, theta in enumerate(angles):

# Create rotation matrix

rotation = np.array([

[np.cos(theta), -np.sin(theta)],

[np.sin(theta), np.cos(theta)]

])

# Rotate the vector

rotated = rotation @ vector

# Plot the rotated vector

plt.arrow(0, 0, rotated[0], rotated[1],

head_width=0.05, head_length=0.1)

plt.text(rotated[0], rotated[1], f'pos {i}')

plt.grid(True)

plt.axis('equal')

plt.title('RoPE: Position-dependent Vector Rotation')

plt.show()

visualize_rope_rotation_simple()La ventaja de este método es que el cálculo de distancias relativas es sencillo (diferencia de ángulos de rotación entre dos posiciones) y no hay límite en la longitud de la secuencia. Además, es posible procesar secuencias más largas que las aprendidas.

Principales cambios en efficient_encoder_rope.py

Clase Embeddings: Se elimina position_embeddings, y se suprime el proceso de agregar incrustaciones de posición en forward(). No es necesario un incrustación de posición separada, ya que RoPE maneja la información de posición.

Función rotate_half: Es la parte central de la operación RoPE.

# (efficient_encoder_rope.py)

def rotate_half(x):

"""Rotates half the hidden dims of the input."""

x1 = x[..., :x.shape[-1] // 2]

x2 = x[..., x.shape[-1] // 2:]

return torch.cat((-x2, x1), dim=-1)apply_rotary_pos_emb función: aplica RoPE a la consulta (q) y la clave (k). # (efficient_encoder_rope.py)

def apply_rotary_pos_emb(q, k, cos, sin):

"""Applies rotary position embeddings to query and key tensors."""

q_embed = (q * cos) + (rotate_half(q) * sin)

k_embed = (k * cos) + (rotate_half(k) * sin)

return q_embed, k_embedFlashAttention clase:cos_cached, sin_cached: Almacena (en caché) los valores de coseno y seno utilizados en RoPE, calculados previamente. Se generan en _build_cache()._build_cache(): Calcula previamente los valores de las funciones trigonométricas necesarios para RoPE.forward(): Después de aplicar la transformación lineal a las consultas y claves, llama a apply_rotary_pos_emb() para aplicar RoPE.import torch

from typing import Optional

import torch.nn as nn

def apply_rotary_pos_emb(q, k, cos, sin):

"""Applies Rotary Position Embeddings to query and key tensors."""

q_embed = (q * cos) + (rotate_half(q) * sin)

k_embed = (k * cos) + (rotate_half(k) * sin)

return q_embed, k_embed

def rotate_half(x):

"""Rotates half the hidden dims of the input."""

x1 = x[..., : x.shape[-1] // 2]

x2 = x[..., x.shape[-1] // 2 :]

return torch.cat((-x2, x1), dim=-1)

class FlashAttention(nn.Module):

# ... (rest of the class definition, unchanged) ...

def _build_cache(self, device, dtype):

if self.cos_cached is not None and self.cos_cached.dtype == dtype: #Return if cache already exist.

return

# Create position indices

pos_seq = torch.arange(self.max_position_embeddings, device=device, dtype=dtype)

# Create freqs (theta in paper)

inv_freq = 1.0 / (10000 ** (torch.arange(0, self.attention_head_size, 2, device=device, dtype=dtype) / self.attention_head_size))

# Create freqs for each position in sequence.

freqs = torch.einsum("i,j->ij", pos_seq, inv_freq)

# Expand the shape for later element-wise calculations

emb = torch.cat((freqs, freqs), dim=-1)

# Create the cos and sin cache

self.cos_cached = emb.cos()[None, None, :, :] # Add head and batch dimensions

self.sin_cached = emb.sin()[None, None, :, :]

def forward(self, hidden_states: torch.Tensor, attention_mask: Optional[torch.Tensor] = None) -> torch.Tensor:

# ... (rest of the forward method, unchanged) ...

# Apply RoPE

batch_size, num_heads, seq_len, head_dim = query_layer.shape

self._build_cache(query_layer.device, query_layer.dtype)

cos = self.cos_cached[:, :, :seq_len, :head_dim]

sin = self.sin_cached[:, :, :seq_len, :head_dim]

query_layer, key_layer = apply_rotary_pos_emb(query_layer, key_layer, cos, sin)

# ... (rest of the forward method, unchanged) ...Utilizamos dos versiones del codificador eficiente (efficient_encoder_rope.py y efficient_encoder.py) para realizar experimentos de clasificación de texto en el conjunto de datos AG News (que clasifica artículos de noticias en 4 categorías). El código para ejecutar el entrenamiento es train_ag_news.py.

El conjunto de datos AG News está compuesto por artículos de noticias equilibrados en cada categoría. Cada artículo se limita a una longitud máxima de 128 tokens, y realizamos un entrenamiento comparativo utilizando dos tokenizadores: BERT y T5. Clasificamos los textos de noticias en las categorías World, Sports, Business, Sci/Tech. La escala del modelo se configuró muy pequeña, como sigue.

vocab_size: int = 30522,

hidden_size: int = 256,

num_hidden_layers: int = 4,

num_attention_heads: int = 8,

intermediate_size: int = 512,

hidden_dropout_prob: float = 0.1,

attention_probs_dropout_prob: float = 0.1,

max_position_embeddings: int = 512,

layer_norm_eps: float = 1e-12Lo siguiente es la sección de ejecución para realizar experimentos de comparación.

from dldna.chapter_09.encoder.train_ag_news import train_and_test_all_versions

train_and_test_all_versions(verbose=False)Resultados de entrenamiento

| Versión del modelo | Tokenizador | Precisión en prueba (%) | Notas |

|---|---|---|---|

| v1 | bert-base-uncased | 91.24 | FlashAttention |

| v1 | t5-small | 92.00 | FlashAttention |

| v2 | bert-base-uncased | 92.57 | RoPE, FlashAttention |

| v2 | t5-small | 92.07 | RoPE, FlashAttention |

efficient_encoder.py (sin RoPE)efficient_encoder_rope.py (con RoPE)Interpretación de resultados

Efecto de RoPE (v2): Al usar el tokenizador bert-base-uncased, el modelo v2 con RoPE mostró una precisión 1.33%p mayor que el modelo v1. Esto sugiere que RoPE codifica la información posicional de manera más efectiva, mejorando el rendimiento del modelo. En particular, cuando se deben procesar secuencias más largas que los datos de entrenamiento (extrapolación de longitud), las ventajas de RoPE pueden ser más notables.

Influencia del tokenizador: Al usar el tokenizador t5-small, ambas versiones mostraron un nivel similar de precisión al utilizar bert-base-uncased. Sin embargo, v2 presentó un rendimiento ligeramente mejor.

Rendimiento alto en general: Ambas versiones lograron una alta precisión superior al 91% en el conjunto de datos AG News. Esto indica que la arquitectura del modelo es efectiva y que se han aplicado bien técnicas modernas de entrenamiento de Transformers, como el uso de F.scaled_dot_product_attention para FlashAttention (cuando el entorno lo soporta), Pre-LN, GELU, inicialización Xavier, AdamW y programación de tasa de aprendizaje.

Comparación con modelos similares (tabla)

La tabla siguiente compara el rendimiento del modelo con otros modelos de tamaño similar en el conjunto de datos AG News. (La precisión puede variar según la literatura y los resultados experimentales.)

| Modelo | Precisión (%) |

|---|---|

| Nuestro modelo v1 | 91.24 |

| Nuestro modelo v2 | 92.57 |

| DistilBERT | 90.36 |

| BERT-base | 91.10 |

| RoBERTa-base | 92.84 |

| modelo | hidden_size |

| ———————————— | ———- |

| Efficient Encoder (v2, bert) | 256 |

| Efficient Encoder (v2, t5) | 256 |

| Efficient Encoder (v1, bert) | 256 |

| Efficient Encoder (v1, t5) | 256 |

| TinyBERT (4 capas, hidden_size=312) | 312 |

| BERT-small | 512 |

| DistilBERT-base | 768 |

| BERT-base | 768 |

mecanismos aplicados | Mecanismo | v1 (efficient_encoder.py) | v2 (efficient_encoder_rope.py) | Nota | | ———————— | ———————- | ——————- | —————————— | | FlashAttention | O | O | Optimización utilizando la estructura de memoria de GPU | | Pre-LN | O | O | Aplicación de Layer Normalization antes de la atención/FFN | | RoPE | X | O | Codificación de información posicional mediante matrices rotacionales | | Incrustaciones de posición aprendibles | O | X | Representación de información posicional cuando no se usa RoPE | | Inicialización Xavier | O | O | Método de inicialización de pesos | | Función de activación GELU | O | O | Función de activación no lineal (usada en FFN) | | Dropout | O | O | Mejora del rendimiento de generalización | | Normalización por capa | O | O | Estabilización y mejora del rendimiento durante el aprendizaje | | Uso de tokenizador preentrenado | O | O | BERT-base-uncased, t5-small utilizado |

Conclusión