Code

!pip install dldna[colab] # in Colab

# !pip install dldna[all] # in your local

%load_ext autoreload

%autoreload 2“Effizienz ist die Brücke zur Intelligenz.” - Alan Turing

Seit dem Erscheinen des Transformers im Jahr 2017 folgen nacheinander riesige Sprachmodelle wie BERT und GPT. Diese haben mit ihren erstaunlichen Leistungen eine neue Ära der Künstlichen Intelligenz eingeleitet. Doch hinter diesem Erfolg standen die grundlegenden Grenzen der Transformer-Architektur und die Anstrengungen, diese zu überwinden. Es gab kontinuierliche Verbesserungen und Strukturvorschläge, um Berechnungskomplexität und Einschränkungen bei der Verarbeitung langer Texte zu bewältigen. Insbesondere seit 2019 wurde mit dem raschen Wachstum der Modellgröße die Forschung zur Effizienz intensiv betrieben.

Wichtige Veränderungen nach Zeitabschnitten:

In diesem Kapitel untersuchen wir die Grenzen der Transformer und gehen detailliert auf verschiedene Methoden ein, um diese zu überwinden.

Herausforderung: Wie kann man die Berechnungskomplexität und den Speicherverbrauch von Transformer-Modellen reduzieren, um längere Kontexte zu verarbeiten und größere Modelle zu trainieren?

Forschungsfrust: Die Leistung der Transformer-Modelle war hervorragend, aber ihre Berechnungskosten waren immens. Insbesondere das Aufmerksamkeitsmechanismus hatte eine Komplexität, die quadratisch mit der Sequenzlänge wuchs und dies begrenzte die Skalierbarkeit des Modells erheblich. Die Forscher mussten Wege finden, um die Berechnungseffizienz zu steigern, während sie die Kernfunktionen des Aufmerksamkeitsmechanismus beibehielten. Es ging nicht nur darum, die Größe des Modells zu reduzieren, sondern auch innovative Lösungen auf algorithmischer und hardwaretechnischer Ebene zu suchen. Dies war eine schwierige Aufgabe, ähnlich wie bei dem Bau eines riesigen Gebäudes, bei der das Gewicht und die Kosten jedes einzelnen Steins verringert werden mussten.

Die quadratische Komplexität des Aufmerksamkeitsmechanismus, die begrenzte Kontextlänge und Probleme der Speichereffizienz waren die wichtigsten Hindernisse für die Modellskalierung. Diese Grenzen wurden entscheidende Faktoren bei der Bestimmung der Entwicklungsrichtung der Transformer.

Bei der Skalierung des Transformer-Modells war die Komplexität des Aufmerksamkeitsmechanismus, insbesondere die quadratische Abhängigkeit von der Sequenzlänge, ein großes Problem.

Analyse der Aufmerksamkeitskomplexität:

\(Attention(Q, K, V) = softmax(\frac{QK^T}{\sqrt{d_k}})V\)

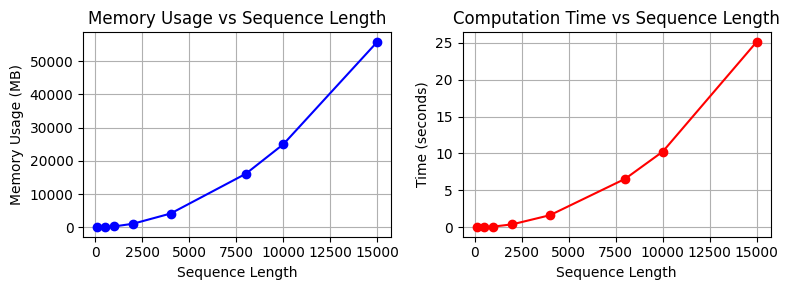

Wir werden dies in einem tatsächlichen Code demonstrieren, um die Ausführungszeit und den Speicherverbrauch zu zeigen.

!pip install dldna[colab] # in Colab

# !pip install dldna[all] # in your local

%load_ext autoreload

%autoreload 2from dldna.chapter_09.complexity_benchmark import measure_attention_complexity, plot_complexity_analysis, measure_attention_complexity_gpu

seq_lengths = [100, 500, 1000, 2000, 4000, 8000, 10000, 15000]

results = measure_attention_complexity(seq_lengths=seq_lengths)

print("\n=== Complexity Analysis of Attention Operation ===")

print("\nMemory usage and execution time by sequence length:")

print("Length\t\tMemory (MB)\tTime (seconds)")

print("-" * 40)

for seq_len, mem, time_taken in results:

print(f"{seq_len}\t\t{mem:.2f}\t\t{time_taken:.4f}")

# Visualize with a graph

plot_complexity_analysis(results)

=== Complexity Analysis of Attention Operation ===

Memory usage and execution time by sequence length:

Length Memory (MB) Time (seconds)

----------------------------------------

100 18.75 0.0037

500 96.58 0.0388

1000 317.00 0.1187

2000 1119.00 0.4228

4000 4188.14 1.6553

8000 16142.53 6.5773

10000 25039.31 10.2601

15000 55868.54 25.1265

In real Transformer models, this operation is repeated across multiple layers. When the batch size increases, the computational load also increases.

# Compare theoretical complexity with actual measurements

print("\n=== Comparison of Theoretical Complexity and Actual Measurements ===")

base_seq = seq_lengths[0]

base_mem = results[0][1]

base_time = results[0][2]

print("\nTheoretical vs Actual Growth Rate (Base: First Sequence Length)")

print("Length Theoretical(N²) Actual Memory Actual Time")

print("-" * 60)

for seq_len, mem, time_taken in results:

theoretical = (seq_len/base_seq) ** 2

actual_mem = mem/base_mem

actual_time = time_taken/base_time

print(f"{seq_len:6d} {theoretical:10.2f}x {actual_mem:10.2f}x {actual_time:10.2f}x")

=== Comparison of Theoretical Complexity and Actual Measurements ===

Theoretical vs Actual Growth Rate (Base: First Sequence Length)

Length Theoretical(N²) Actual Memory Actual Time

------------------------------------------------------------

100 1.00x 1.00x 1.00x

500 25.00x 5.15x 8.05x

1000 100.00x 16.91x 32.49x

2000 400.00x 59.71x 124.52x

4000 1600.00x 223.34x 474.71x

8000 6400.00x 860.92x 1882.04x

10000 10000.00x 1335.43x 2976.84x

15000 22500.00x 2979.67x 7280.40xDie quadratische Komplexität ist bei großen Modellen wie GPT-3 besonders ernst. Sie hat viele Einschränkungen verursacht, wie die Begrenzung der Verarbeitung langer Dokumente und die Beschränkung der Batch-Größe während des Trainings. Dies war ein wesentlicher Anreiz für die Entwicklung effizienter Aufmerksamkeitsmechanismen.

Die ersten Versuche zur Lösung des Problems der quadratischen Komplexität in Transformers gingen in drei Hauptrichtungen.

Sliding Window Attention

Berechnet die Aufmerksamkeit nur innerhalb eines festen Fensters.

def sliding_window_attention(q, k, v, window_size):

"""Sliding window attention"""

batch_size, seq_len, dim = q.shape

attention_weights = np.zeros((batch_size, seq_len, seq_len))

for i in range(seq_len):

start = max(0, i - window_size // 2)

end = min(seq_len, i + window_size // 2 + 1)

scores = np.matmul(q[:, i:i+1], k[:, start:end].transpose(0, 2, 1))

attention_weights[:, i, start:end] = softmax(scores, axis=-1)

return np.matmul(attention_weights, v)Diese Methode reduziert die Komplexität auf \(O(N \cdot w)\) (w: Fenstergröße).

Spärliche Aufmerksamkeitsmuster

Spärliche Aufmerksamkeitsmuster berechnen anstelle der Beziehungen aller Token-Paare nur bestimmte Beziehungen nach einem spezifischen Muster. Zum Beispiel, bei einer Sequenz mit 10 Token berechnet die normale Aufmerksamkeit alle 100 (10×10) Beziehungen, während spärliche Aufmerksamkeit nur eine Teilmenge davon berechnet.

def sparse_block_attention(q, k, v, block_size):

"""Block sparse attention

Example: seq_len=8, block_size=2

Process the sequence in 4 blocks of 2 tokens each

Block 1 (0,1), Block 2 (2,3), Block 3 (4,5), Block 4 (6,7)

"""

batch_size, seq_len, dim = q.shape # e.g., (1, 8, 64)

num_blocks = seq_len // block_size # e.g., 8/2 = 4 blocks

attention_weights = np.zeros((batch_size, seq_len, seq_len))

for i in range(num_blocks):

# e.g., when i=0, process Block 1 (0,1)

start_q = i * block_size # 0

end_q = (i + 1) * block_size # 2

for j in range(num_blocks):

# e.g., when j=0, attention with Block 1 (0,1)

start_k = j * block_size # 0

end_k = (j + 1) * block_size # 2

# Calculate attention between tokens in Block 1 (0,1) and Block 1 tokens (0,1)

scores = np.matmul(

q[:, start_q:end_q], # (1, 2, 64)

k[:, start_k:end_k].transpose(0, 2, 1) # (1, 64, 2)

) # Result: (1, 2, 2)

# Store weights block by block

attention_weights[:, start_q:end_q, start_k:end_k] = softmax(scores, axis=-1)

# Generate the final context vectors

return np.matmul(attention_weights, v)Niedrigrang-Approximation

Niedrigrang-Approximation ist eine Methode, bei der große Matrizen als Produkt kleinerer Matrizen dargestellt werden. Zum Beispiel berechnet die übliche Aufmerksamkeit in einem Satz mit 10 Token 10×10=100 Beziehungen, während Niedrigrang-Approximation dies als das Produkt von zwei Matrizen, 10×4 und 4×10 (Rang=4), darstellt. Somit können ähnliche Ergebnisse mit nur 80 Operationen anstelle von 100 erzielt werden.

def low_rank_attention(q, k, v, rank):

"""Low-rank attention

Example: seq_len=10, dim=64, rank=16

Project Q, K from 64 dimensions to 16 dimensions to reduce computation

"""

batch_size, seq_len, dim = q.shape # e.g., (1, 10, 64)

# Create projection matrices to project from 64 dimensions to 16 dimensions

projection_q = np.random.randn(dim, rank) / np.sqrt(rank) # (64, 16)

projection_k = np.random.randn(dim, rank) / np.sqrt(rank)

# Project Q, K to 16 dimensions

q_low = np.matmul(q, projection_q) # (1, 10, 16)

k_low = np.matmul(k, projection_k) # (1, 10, 16)

# Calculate attention in the lower dimension (operations on 10x16 matrices)

attention = np.matmul(q_low, k_low.transpose(0, 2, 1)) # (1, 10, 10)

attention_weights = softmax(attention, axis=-1)

# Generate the final context vectors

return np.matmul(attention_weights, v) # (1, 10, 64)Diese Methode konnte die Komplexität auf \(O(N \cdot r)\) reduzieren. Hierbei ist r der Rang, der für die Approximation verwendet wurde. Lassen Sie uns die Effizienz jeder Methode berechnen.

from dldna.chapter_09.attention_complexity_examples import calcualte_efficieny

calcualte_efficieny()Original input shape: (2, 8, 4)

1. Sliding Window Attention

Output shape: (2, 8, 4)

Output of the first batch, first token: [-0.78236164 0.22592055 -1.03027549 1.13998368]

2. Block Sparse Attention

Output shape: (2, 8, 4)

Output of the first batch, first token: [-1.66095776 0.76700744 -0.45857165 -0.77422867]

3. Low-Rank Attention

Output shape: (2, 8, 4)

Output of the first batch, first token: [ 0.51121005 0.66772692 -0.77623488 -0.0323534 ]

Memory Usage Comparison (Relative Size):

Full Attention: 64

Sliding Window: 32

Block Sparse: 64

Low Rank: 32Jedoch zeigten die frühen Versuche Grenzen wie Informationsverlust, implementatorische Komplexität und Leistungsabfall. Google konzentrierte sich auf Niedrigrang-Approximationen, während Microsoft sich auf die Entwicklung von dünnbesetzten Mustern fokussierte. Später entwickelten sich diese frühen Ansätze zu hybriden Methoden weiter, die sowohl Dünnbesetztheit als auch Niedrigrang-Eigenschaften nutzen.

Ein weiterer wichtiger Grenzwert ist die Speichereffizienz. Besonders bei großen Sprachmodellen gibt es folgende Speicherbelastungen.

Erstens, die Speicherbelastung durch KV-Cache. Im auto-regressiven Generierungsprozess müssen die Key- und Value-Werte aus den vorherigen Zeitpunkten gespeichert werden, was linear mit der Sequenzlänge ansteigt. Zum Beispiel benötigt GPT-3 bei der Verarbeitung von 2048 Token etwa 16 MB KV-Cache pro Schicht. Zweitens, die Speicheranforderungen des Backpropagation-Prozesses. Transformatoren speichern die Zwischenaktivierungswerte (activation values) - die Zwischenergebnisse der Berechnungen in den Aufmerksamkeits-Schichten (Q, K, V-Transformationen, Aufmerksamkeitswerte, Softmax-Ausgaben usw.) - was mit steigender Anzahl von Schichten stark zunimmt. BERT-large benötigte etwa 24 GB Speicher für einen einzelnen Batch. Drittens, der Speicherverbrauch durch die Aufmerksamkeits-Operationen selbst. Die Matrix der Aufmerksamkeitswerte hat eine Größe, die quadratisch zur Sequenzlänge ansteigt, was bei der Verarbeitung langer Dokumente ein ernsthaftes Engpassproblem darstellen kann.

Um diese Speicherprobleme zu lösen, wurden Optimierungstechniken wie Gradienten-Checkpointing, gemischte Präzisionstraining und FlashAttention vorgeschlagen.

Um die in Abschnitt 9.1.1 und 9.1.2 besprochenen Berechnungskomplexität und Speichereffizienzgrenzen von Transformatoren zu überwinden, haben Forscher verschiedene Techniken entwickelt, um Effizienz und Skalierbarkeit zu verbessern. Diese Techniken haben die Transformer-Modelle stärker und praktischer gemacht und einen großen Einfluss auf das gesamte Deep-Learning-Feld ausgeübt.

In diesem Kapitel geben wir wie in der folgenden Tabelle den zeitlichen Verlauf der Entwicklung von Transformatoren, die wichtigsten Techniken und Modelle für jede Periode sowie ihre Kerninhalte und Deep-Learning-DNA wieder.

Tabelle: Zeitlicher Verlauf der Entwicklung von Transformatoren, wichtige Modelle/Techniken, Kerninhalte, Deep-Learning-DNA | Sektion | Zeitraum (ungefähr) | Hauptmodelle/Techniken | Kernpunkte und Erklärungen | Deep Learning DNA | |———–|———————-|——————————|————————————|————————————————-| | 9.1 | 2017-2018 | Transformer | Einführung des Attention-Mechanismus, um die Limitierungen von RNN und CNN zu überwinden.

Revolutionierung der Sequence-to-sequence-Modelle | Attention-Mechanismus: Neue Methode zur Fokussierung auf wichtige Teile der Daten | | 9.2 | 2019-2020 | Performer, Sparse Transformer, Longformer

Reformer, BigBird | Software-gestützter Ansatz zur Reduzierung der Berechnungskomplexität.

Lineare Attention: Approximation von Attention-Berechnungen (Performer).

Spärliche Attention: Anwendung von Attention nur auf bestimmte Token-Paare (Sparse Transformer, Longformer).

Lokal-Globale Attention: Kombination lokaler und globaler Informationen (Reformer, BigBird) | Effiziente Attention: Bemühungen, die Vorzüge der Attention bei reduzierter Berechnungskomplexität zu bewahren.

Langdistanz-Abhängigkeiten: Verbesserung der Struktur zur effektiven Verarbeitung langer Kontexte | | 9.3 | 2021-2022 | FlashAttention, MQA, GQA, PagedAttention, vLLM | Hardware- und softwaregestützter Ansatz zur Verbesserung der Speicher-effizienz.

FlashAttention: Nutzung von GPU-Speicherschichten, Tiling, Block-Bearbeitung.

MQA/GQA: Abfrageoptimierung, Key/Value-Teilen.

KV-Cache-Optimierung: PagedAttention, vLLM | Hardware-Optimierung: Effiziente Berechnungsverfahren unter Berücksichtigung der GPU-Speicherstruktur.

Parallelverarbeitung: Erhöhung der Berechnungseffizienz durch Abfrage-Teilung | | 9.4 | 2022-2023 | Claude-2, LongLoRA, Constitutional AI, RLHF,

RLAIF, Hierarchische Attention, Recurrent Memory | Skalierbarkeit und spezielle Anwendungen von Architekturen.

Langer Kontext: Hierarchische Attention, Recurrent Memory Transformer.

Ethik/Sicherheit: Regelbasierte Attention, regelbasierte Anpassung durch Reinforcement Learning | Langer Kontext: Evolution der Modellstrukturen zur Verarbeitung längeren Kontexts.

Feinabstimmung: Methoden zur Anpassung von Modellen für spezifische Zwecke | | 9.5 | 2022-2023 | Effizienter Encoder (auf FlashAttention basierend) | Textkategorisierung (AG News), FlashAttention, Pre-LN, Gradient Checkpointing, Mixed Precision Training | Implementierung: Nutzung eines effizienten Encoders | | 9.6 | 2023 | Mistral, Effizienter Decoder (auf GQA und Sliding Window Attention basierend) | Analyse des Mistral-Modells: GQA, Sliding Window Attention, RoPE, KV-Cache usw.

Anwendungsbeispiele: Zahlentextumwandlung, Natürliche Sprache-SQL-Umsetzung (Codegenerierung), Text-Codegenerierung. | Implementierung: Effiziente Decoderarchitektur | | 9.7 | 2024 | Gemma | Offenes Modell zur Verbesserung von Effizienz und Zugänglichkeit | Offenes Modell: Verbesserung des Zugangs zu Forschung und Entwicklung | | 9.8 | 2024 | Phi-3 | Kleines, aber effizientes LLM | Implementierung: Leistungsfähiges SLM(Small Language Model) | Die Struktur dieses Kapitels ist wie folgt:

Von 2019 bis 2020 wurden verschiedene Versuche unternommen, die Berechnungskomplexität von Transformers zu reduzieren. Insbesondere die in dieser Zeit durch Google Research und DeepMind angeführten Fortschritte verbesserten die Effizienz der Aufmerksamkeitsoperationen erheblich.

Anfang 2020 gelang es einem Team von Google Research, mit FAVOR+ (Fast Attention Via positive Orthogonal Random features) die Komplexität der Aufmerksamkeit von O(N²) auf O(N) zu reduzieren. FAVOR+ ist das zentrale Mechanismus des Performer-Modells und war die erste Methode, die es praktisch machte, lange Sequenzen zu verarbeiten.

Der Kerngedanke von FAVOR+ beginnt mit der Kernel-Trick. Der Kernel-Trick interpretiert die Softmax-Aufmerksamkeit wie folgt:

\(Attention(Q,K,V) = softmax(\frac{QK^T}{\sqrt{d}})V\)

Dies kann durch eine positive Kernel-Funktion φ(x) wie folgt approximiert werden:

\(Attention(Q,K,V) ≈ \frac{\phi(Q)\phi(K)^TV}{\phi(Q)\phi(K)^T\mathbf{1}}\)

Der Kern des Ansatzes besteht darin, die Softmax-Aufmerksamkeit als Bruch zu interpretieren und durch die Verwendung der Kernel-Funktion φ(x) die Reihenfolge der Matrixmultiplikation umzustellen. Es ist ähnlich wie das Umstellen von \((a \times b) \times c\) zu \(a \times (b \times c)\).

import numpy as np

def kernel_attention(Q, K, V, feature_dim=256): # Q: (seq_len, d_model) K: (seq_len, d_model) V: (seq_len, d_model)

# 1. Generate random projection matrix

projection = np.random.randn(Q.shape[-1], feature_dim) / np.sqrt(feature_dim)

# projection: (d_model, feature_dim)

# 2. Project Q, K to lower dimension and apply ReLU

Q_mapped = np.maximum(0, np.dot(Q, projection)) # phi(Q)

# Q_mapped: (seq_len, feature_dim)

K_mapped = np.maximum(0, np.dot(K, projection)) # phi(K)

# K_mapped: (seq_len, feature_dim)

# 3. Calculate numerator: phi(Q)phi(K)^TV

KV = np.dot(K_mapped.T, V) # (feature_dim, V_dim)

# KV: (feature_dim, d_model)

numerator = np.dot(Q_mapped, KV) # (seq_len, V_dim)

# numerator: (seq_len, d_model)

# 4. Calculate denominator: phi(Q)phi(K)^T1

K_sum = np.sum(K_mapped, axis=0, keepdims=True) # (1, feature_dim)

# K_sum: (1, feature_dim)

denominator = np.dot(Q_mapped, K_sum.T) # (seq_len, 1)

# denominator: (seq_len, 1)

# 5. Final attention output

attention_output = numerator / (denominator + 1e-6)

# attention_output: (seq_len, d_model)

return attention_output

# Example usage

seq_len, d_model = 1000, 64

Q = np.random.randn(seq_len, d_model)

K = np.random.randn(seq_len, d_model)

V = np.random.randn(seq_len, d_model)

# Calculate attention with O(N) complexity

output = kernel_attention(Q, K, V)

print(output)[[-0.00705502 -0.01553617 -0.01976792 ... -0.00906909 0.02983678

0.0424082 ]

[-0.00201811 -0.01741265 -0.00458378 ... -0.02578894 0.04247468

0.03793401]

[-0.01130314 -0.02011524 -0.00962334 ... -0.01348429 0.04382548

0.01967338]

...

[ 0.00180466 -0.01818735 -0.02244794 ... -0.01978542 0.03202302

0.03887265]

[-0.00421543 -0.01679868 -0.00537492 ... -0.00314385 0.05363415

0.03304721]

[ 0.00107896 -0.02042812 -0.01947976 ... -0.00557582 0.04534007

0.04408479]]FAVOR+ hat drei wesentliche Veränderungen eingeführt, die folgenden sind:

Die Verarbeitungsschritte von FAVOR+ sind wie folgt:

import numpy as np

def favor_plus_attention(q, k, v, feature_dim=256):

"""FAVOR+ attention implementation

Args:

q: Query tensor (batch_size, seq_len, d_model)

k: Key tensor (batch_size, seq_len, d_model)

v: Value tensor (batch_size, seq_len, d_model)

feature_dim: The number of dimensions of the low-dimensional feature space

"""

d_model = q.shape[-1]

# 1. Generate an orthonormal random projection matrix

random_matrix = np.random.randn(d_model, feature_dim)

q_orth, _ = np.linalg.qr(random_matrix)

projection = q_orth / np.sqrt(feature_dim) # (d_model, feature_dim)

# 2. Project Q, K to the low-dimensional feature space and apply ReLU

q_prime = np.maximum(0, np.matmul(q, projection)) # (batch_size, seq_len, feature_dim)

k_prime = np.maximum(0, np.matmul(k, projection)) # (batch_size, seq_len, feature_dim)

# 3. Calculate linear-time attention

# Use einsum to perform matrix multiplication while maintaining the batch dimension

kv = np.einsum('bsf,bsd->bfd', k_prime, v) # (batch_size, feature_dim, d_model)

# Calculate the numerator

numerator = np.einsum('bsf,bfd->bsd', q_prime, kv) # (batch_size, seq_len, d_model)

# Calculate the denominator (normalization term)

k_sum = np.sum(k_prime, axis=1, keepdims=True) # (batch_size, 1, feature_dim)

denominator = np.einsum('bsf,bof->bso', q_prime, k_sum) # (batch_size, seq_len, 1)

# 4. Calculate the final attention output

attention_output = numerator / (denominator + 1e-6) # (batch_size, seq_len, d_model)

return attention_output

# Example usage

batch_size, seq_len, d_model = 2, 100, 512

q = np.random.randn(batch_size, seq_len, d_model)

k = np.random.randn(batch_size, seq_len, d_model)

v = np.random.randn(batch_size, seq_len, d_model)

output = favor_plus_attention(q, k, v)

print("Output tensor shape:", output.shape)Output tensor shape: (2, 100, 512)FAVOR+ verfügt über folgende Vorteile:

Mathematische Grundlage

Die mathematische Grundlage von FAVOR+ liegt in dem Johnson-Lindenstrauss Lemma. Der Kernpunkt ist, dass Beziehungen zwischen Datenpunkten fast erhalten bleiben, wenn hochdimensionale Daten auf niedrigere Dimensionen projiziert werden. Das heißt, die relative Distanz zwischen Datenpunkten ändert sich kaum, selbst wenn 1000-dimensionale Daten auf 100 Dimensionen reduziert werden.

Der Erfolg von FAVOR+ hat verschiedene lineare Attention-Modelle wie Linear Transformer und Linear Attention Transformer weiterentwickelt und war insbesondere in der Verarbeitung langer Sequenzen von großer Bedeutung.

Im Jahr 2019 führte OpenAI mit dem Sparse Transformer feste dünn besetzte Muster ein. Dies bedeutet, dass anstelle der Berechnung von Beziehungen für jedes Token-Paar nur bestimmte Beziehungen nach einem spezifischen Muster berechnet werden.

Feste Muster des Sparse Transformers

Der Sparse Transformer verwendet zwei Hauptdünnbesetzte Muster:

Diese Muster können durch die folgende mathematische Darstellung ausgedrückt werden:

\(Attention(Q,K,V) = softmax(\frac{QK^T \odot M}{\sqrt{d_k}})V\)

Dabei ist M eine dünnbesetzte Maske-Matrix, und ⊙ repräsentiert das elementweise Produkt. Die Maske-Matrix zeigt an, ob Attention auf ein Token-Paar (1) angewendet wird oder nicht (0).

Diese Methode erhöhte die Berechnungseffizienz, hatte aber den Nachteil, dass die Muster fix waren und sich flexibel anpassen ließen.

Kombination lokaler und globaler Attention im Longformer

2020 schlug Allen AI mit dem Longformer eine flexible dünnbesetzte Struktur vor. Der Longformer verwendet einen hybriden Ansatz, der lokale Attention und globale Attention kombiniert.

Diese Methode ermöglicht es, sowohl den lokalen als auch den globalen Kontext gleichzeitig zu berücksichtigen und eine reichhaltigere Kontextverarbeitung zu erzielen.

| Korean | German |

|---|---|

| Hallo! | Hallo! |

| Dies ist ein Test. | Dies ist ein Test. |

| \(x^2 + y^2 = z^2\) ist der Satz des Pythagoras. | \(x^2 + y^2 = z^2\) ist der Satz des Pythagoras. |

import numpy as np

def longformer_attention(q, k, v, window_size=3, global_tokens=[0]):

"""Longformer attention implementation

Args:

q, k, v: (batch_size, seq_len, d_model)

window_size: Size of the local attention window

global_tokens: List of token indices to perform global attention on

"""

batch_size, seq_len, d_model = q.shape

attention_weights = np.zeros((batch_size, seq_len, seq_len))

# 1. Local attention: sliding window

for i in range(seq_len):

# Calculate window range

window_start = max(0, i - window_size)

window_end = min(seq_len, i + window_size + 1)

window_size_current = window_end - window_start

# Calculate attention scores within the window

scores = np.matmul(q[:, i:i+1], k[:, window_start:window_end].transpose(0, 2, 1))

# scores: (batch_size, 1, window_size_current)

attention_weights[:, i:i+1, window_start:window_end] = scores

# 2. Global attention: specific tokens attend to all tokens

for global_idx in global_tokens:

# Calculate attention scores for global tokens

scores = np.matmul(q[:, global_idx:global_idx+1], k.transpose(0, 2, 1))

# scores: (batch_size, 1, seq_len)

attention_weights[:, global_idx:global_idx+1, :] = scores

attention_weights[:, :, global_idx:global_idx+1] = scores.transpose(0, 2, 1)

# 3. Apply softmax (row-wise)

attention_weights = np.exp(attention_weights) / np.sum(np.exp(attention_weights), axis=-1, keepdims=True)

# 4. Calculate the final output by applying weights

output = np.matmul(attention_weights, v) # (batch_size, seq_len, d_model)

return output

# Example usage

batch_size, seq_len, d_model = 2, 10, 64

q = np.random.randn(batch_size, seq_len, d_model)

k = np.random.randn(batch_size, seq_len, d_model)

v = np.random.randn(batch_size, seq_len, d_model)

output = longformer_attention(q, k, v, window_size=2, global_tokens=[0])

print(output)[[[-0.72195324 0.03196266 -0.06067346 ... 0.57106283 1.31438

0.63673636]

[-1.72619367 -0.39122625 0.91285828 ... -1.4031466 1.2081069

0.95934394]

[ 0.07427921 0.42596224 -0.44545069 ... 0.154228 0.37435003

-0.01884786]

...

[ 1.26169539 -0.58215291 2.00334263 ... 1.15338425 0.31404728

-1.33672458]

[ 0.96005607 0.39904084 0.5703471 ... -0.2168805 0.93570179

0.05680507]

[ 0.61648602 -0.12874142 1.09736967 ... 0.32421211 1.23082505

0.4141766 ]]

[[ 0.92762851 0.26334678 -0.81047846 ... -0.19186621 0.42534117

0.57313974]

[ 1.01307261 0.61571205 -1.26925081 ... -0.56016688 -0.19707427

2.49452497]

[-1.0071559 2.81291178 2.5010486 ... 1.63559632 -0.60892113

-1.40952186]

...

[-1.96615634 1.85881047 0.19361453 ... 1.21044747 -0.00772792

-0.68961122]

[ 0.09090778 1.94770672 -0.990489 ... -0.09841141 0.65195305

0.11634795]

[-2.43256801 1.66319642 0.23557316 ... 2.39325846 0.8750332

0.66295002]]]Optimierung von Block-Sparsity-Matrix-Operationen

Um den hybriden Ansatz des Longformer effizient zu implementieren, sind Optimierungen von Block-Sparsity-Matrix-Operationen notwendig.

Der ansatzbasierte Vorgehen mit dünnen Mustern reduzierte die Komplexität auf O(N log N) oder O(N), stieß aber auf Implementierungskomplexität und Schwierigkeiten bei der Hardwareoptimierung.

Anfang 2020 schlugen Google Research und Allen AI einen hybriden Ansatz vor, der lokale und globale Aufmerksamkeit kombiniert. Dies war ein Versuch, die Informationsverluste linearer Aufmerksamkeit und die Implementierungskomplexität dünn besetzter Muster zu lösen.

Der Reformer nutzt Lokalitäts-sensitive Hashing (Locality-Sensitive Hashing, LSH), um ähnliche Vektoren effizient zu gruppieren. Das Kernprinzip von LSH ist wie folgt.

\(h(x) = \text{argmax}( [xR; -xR] )\)

Dabei ist R eine Matrix für zufällige Projektionen und ähnliche Vektoren haben eine hohe Wahrscheinlichkeit, den gleichen Hashwert zu erhalten. Der Reformer verfolgt die folgenden Schritte.

Dieser Ansatz ist effizient bei der Verarbeitung langer Sequenzen, kann aber durch Hash-Kollisionen zu Informationsverlust führen.

BigBird kombiniert drei Arten von Aufmerksamkeitsmustern, um die Grenzen des Reformers zu überwinden.

Diese Struktur erreicht eine Komplexität von O(N), während sie die Leistung auf BERT-Niveau beibehält.

Einfluss hybrider Muster

Der Erfolg des BigBird hat das Potenzial der lokalen-globalen Ansätze bewiesen und hatte einen großen Einfluss auf moderne Transformer-Modelle.

Von 2021 bis 2022 stand der Fokus auf der Steigerung der Speichereffizienz von Transformers. Insbesondere wurden Optimierungen im Hinblick auf die GPU-Speicherhierarchie und effiziente Implementierungen des Aufmerksamkeitsmechanismus hervorgehoben. Die Methoden dieser Zeit ermöglichten praktische Implementierungen großer Sprachmodelle.

Im Jahr 2022 schlug das Forschungsteam von Tri Dao an der Stanford University FlashAttention vor, das die GPU-Speicherhierarchie berücksichtigt. Dies war eine hardwarezentrierte Verbesserung, die die Speicherzugriffsmuster des Aufmerksamkeitsmechanismus grundlegend neu gestaltet hat. FlashAttention verbesserte die Trainings- und Inferenzgeschwindigkeit von Transformermodellen, insbesondere solchen mit langen Sequenzen, erheblich und trug wesentlich zur Entwicklung großer Sprachmodelle bei. Die im Jahr 2023 veröffentlichte FlashAttention v2 optimierte das originale FlashAttention weiter und erreichte eine Geschwindigkeitssteigerung von 2-4 Mal.

Ein Vorteil von FlashAttention ist, dass es die GPU-Speicherhierarchie explizit berücksichtigt. GPUs verfügen über zwei Arten von Speicher: das große, aber langsame HBM (High Bandwidth Memory) und das kleine, aber schnelle SRAM. HBM hat eine große Kapazität, ist aber langsamer zu accessieren; SRAM hat eine geringere Kapazität, aber sehr schnellen Zugriff. FlashAttention nutzt diese Eigenschaften.

Diese Blockverarbeitungsstrategie minimiert den Verbrauch der Speicherbandbreite und ermöglicht gleichzeitig eine präzise Berechnung des Aufmerksamkeitsmechanismus.

FlashAttention v2 behielt die grundlegenden Ideen von v1 bei, fügte aber mehrere niedriglevel-Optimierungen hinzu, um die Hardwarenutzung zu maximieren. Es erzielte eine Geschwindigkeitssteigerung von 2-4 Mal im Vergleich zu v1 und zeigte insbesondere bei der Verarbeitung langer Sequenzen hervorragende Leistungsmerkmale. * Kernelfusion: FlashAttention v2 integriert verschiedene Operationen des Aufmerksamkeitsmechanismus wie die Transformation von Query, Key und Value, das Berechnen der Aufmerksamkeitswerte, Softmax sowie das gewichtete Durchschnittsberechnung in einen einzigen CUDA-Kernel. Dadurch wird die Anzahl der Speicherzugriffe auf das HBM minimiert, um den Speicherbandbreitenverbrauch zu reduzieren und die Geschwindigkeit zu steigern. * Nicht-sequenzielle (Non-sequential) Aufmerksamkeitskopfverarbeitung: Statt die Aufmerksamkeitsköpfe sequenziell zu verarbeiten, behandelt FlashAttention V2 sie parallel, soweit dies von den GPU-Ressourcen erlaubt wird. Dies verringert die Verzögerungszeit. * Cache-freundliches Speicherlayout: Daten werden in Spaltenmajor-Reihenfolge gespeichert und datenstrukturelle Anpassungen vorgenommen, um besser mit den GPU-Cachezeilen abzustimmen. Dies reduziert Cache-Misses und verbessert die Geschwindigkeit des Datenzugriffs. * Warp-level Parallelisierung: Die Verarbeitungsteile der Aufmerksamkeitsoperationen werden so optimiert, dass sie innerhalb eines CUDA-Warps mit 32 Threads möglichst parallel ausgeführt werden. Dies nutzt maximale SIMD- (Single Instruction, Multiple Data) und parallele Verarbeitungsfähigkeiten der GPU aus, um die Berechnungsgeschwindigkeit zu erhöhen.

Durch diese umfassende Optimierung konnte FlashAttention v2 in bestimmten Umgebungen eine bis zu 20-fache Steigerung der Speichereffizienz und eine Geschwindigkeitssteigerung von 2-4-fach im Vergleich zur herkömmlichen PyTorch-Aufmerksamkeitsimplementierung erzielen. Der Erfolg von FlashAttention unterstreicht die Bedeutung einer tiefen Verständnis der Hardwareeigenschaften bei der Algorithmusentwicklung und wurde zu einem Kernbestandteil großer Sprachmodelle wie GPT-4, Claude usw.

Die offizielle Implementierung von FlashAttention ist in NVIDIA CUDA-Code verfügbar. In PyTorch kann es über das flash-attn-Paket verwendet werden und wird auch in der neuesten Version der Hugging Face Transformers-Bibliothek integriert.

Im Jahr 2022 schlug Google Research mit dem PaLM-Modell Multi-Query Attention (MQA) vor, um die Speichereffizienz von der Softwareseite aus zu verbessern. Im Gegensatz zur hardwarezentrierten Optimierung von FlashAttention handelt es sich hierbei um einen Ansatz, bei dem die Aufmerksamkeitsstruktur selbst neu gestaltet wird, um den Speicherbedarf zu reduzieren.

Das Kernstück des MQA ist die Änderung der Designstruktur so, dass alle Aufmerksamkeitsköpfe dieselben Key und Value teilen.

import numpy as np

def multi_query_attention(q, k, v, num_heads):

"""Multi-Query Attention implementation

Args:

q: (batch_size, seq_len, d_model)

k: (batch_size, seq_len, d_model)

v: (batch_size, seq_len, d_model)

num_heads: Number of heads

"""

batch_size, seq_len, d_model = q.shape

head_dim = d_model // num_heads

# 1. Convert K, V to single matrices shared by all heads

k_shared = np.dot(k, np.random.randn(d_model, d_model)) # (batch_size, seq_len, d_model)

v_shared = np.dot(v, np.random.randn(d_model, d_model)) # (batch_size, seq_len, d_model)

# 2. Generate Q differently for each head

q_multi = np.dot(q, np.random.randn(d_model, num_heads * head_dim)) # (batch_size, seq_len, num_heads * head_dim)

q_multi = q_multi.reshape(batch_size, seq_len, num_heads, head_dim) # (batch_size, seq_len, num_heads, head_dim)

# Transform k_shared to head_dim size

k_shared = np.dot(k_shared, np.random.randn(d_model, head_dim)) # (batch_size, seq_len, head_dim)

# 3. Calculate attention scores

scores = np.matmul(q_multi, k_shared.reshape(batch_size, seq_len, head_dim, 1))

# scores: (batch_size, seq_len, num_heads, 1)

# 4. Apply softmax

weights = np.exp(scores) / np.sum(np.exp(scores), axis=-1, keepdims=True)

# weights: (batch_size, seq_len, num_heads, 1)

# 5. Multiply V with weights

v_shared = np.dot(v_shared, np.random.randn(d_model, head_dim)) # Transform V to head_dim as well

v_shared = v_shared.reshape(batch_size, seq_len, 1, head_dim)

output = np.matmul(weights, v_shared)

# output: (batch_size, seq_len, num_heads, head_dim)

# 6. Concatenate heads and transform output

output = output.reshape(batch_size, seq_len, num_heads * head_dim)

output = np.dot(output, np.random.randn(num_heads * head_dim, d_model))

# output: (batch_size, seq_len, d_model)

return output

# Example usage

batch_size, seq_len, d_model = 2, 100, 512

num_heads = 8

q = np.random.randn(batch_size, seq_len, d_model)

k = np.random.randn(batch_size, seq_len, d_model)

v = np.random.randn(batch_size, seq_len, d_model)

output = multi_query_attention(q, k, v, num_heads)

print("Output tensor shape:", output.shape)/tmp/ipykernel_304793/3750479510.py:30: RuntimeWarning: overflow encountered in exp

weights = np.exp(scores) / np.sum(np.exp(scores), axis=-1, keepdims=True)

/tmp/ipykernel_304793/3750479510.py:30: RuntimeWarning: invalid value encountered in divide

weights = np.exp(scores) / np.sum(np.exp(scores), axis=-1, keepdims=True)Output tensor shape: (2, 100, 512)Anfang 2023 schlug Meta AI GQA (Gruppierte-Abfrage-Aufmerksamkeit) vor, um die Grenzen der MQA zu überwinden. GQA nimmt einen mittleren Ansatz, indem es die Köpfe in Gruppen zusammenfasst und jede Gruppe K, V teilt.

Abfrageoptimierte Strukturen wie MQA und GQA bieten die folgenden Trade-offs:

| Struktur | Speicherverwendung | Ausdrucksfähigkeit | Verarbeitungsgeschwindigkeit | Implementierungskomplexität |

|---|---|---|---|---|

| Multi-Head Attention | N × H | hoch | langsam | niedrig |

| GQA | N × G | mittel | mittel | mittel |

| MQA | N | niedrig | schnell | niedrig |

(N: Sequenzlänge, H: Anzahl der Köpfe, G: Anzahl der Gruppen)

Diese Strukturen werden in modernen großen Sprachmodellen wie LLaMA, PaLM und Claude weitgehend adoptiert und verbessern insbesondere die Speichereffizienz bei der Verarbeitung langer Sequenzen.

Ende 2022 erkannten DeepMind, Anthropic und das vLLM-Entwicklungsteam die Bedeutung der KV-Cache-Verwaltung während des Inferenzprozesses in großen Sprachmodellen. Sie schlugen Software- und Systemebenen-Memory-Optimierungsstrategien vor, um die hardwarezentrierte Ansätze von FlashAttention und die strukturellen Ansätze von MQA/GQA zu ergänzen. Dies ist insbesondere bei der Verarbeitung langer Konversationen, dem Generieren langer Dokumente und wenn ein hoher Durchsatz (throughput) erforderlich ist, wichtig.

PagedAttention und seine Implementierung in vLLM sind Techniken zur effizienten Verwaltung von KV-Caches, die sich aus dem virtuellen Speicher- und Paging-Konzept des Betriebssystems ableiten.

Probleme mit traditionellen KV-Caches

Kernidee von PagedAttention

Vorteile von PagedAttention

vLLM: Hochleistungs-Inferenz-Engine mit PagedAttention

vLLM ist eine Open-Source-Bibliothek, die durch die Verwendung von PagedAttention als Kernfunktion die Inferenzgeschwindigkeit und den Durchsatz großer Sprachmodelle erheblich verbessert.

Kontinuierliches Batching ist eine Kernfunktion, um den Durchsatz (throughput) bei der Verarbeitung großer Sprachmodelle zu maximieren. PagedAttention und vLLM unterstützen kontinuierliches Batching effizient.

Probleme der traditionellen Batch-Verarbeitung

Kernidee des kontinuierlichen Batchings

Effiziente Caching-Strategien

Mit kontinuierlichem Batching können folgende Caching-Strategien verwendet werden, um die Speichereffizienz weiter zu verbessern:

Zusammenfassung

Diese Technologien sind entscheidend für die Bereitstellung großer Sprachmodelle in realen Diensten und zur Erreichung hoher Durchsatzraten und niedriger Latenzen.

Ab 2023 hat die Entwicklung von Transformer-Modellen eine neue Phase erreicht, die über Effizienz hinaus die Skalierbarkeit und spezielle Anwendungen berücksichtigt. Die in früheren Phasen (Kapitel 9.2, 9.3) erworbenen grundlegenden Technologien wie FlashAttention, MQA/GQA und effiziente KV-Cache-Verwaltung bildeten die Grundlage für die Lösung größerer und komplexerer Probleme. Auf dieser technischen Weiterentwicklung basierend begannen Forscher nicht nur, die Größe der Modelle zu vergrößern, sondern auch optimierte Strukturen für bestimmte Problemfelder zu entwickeln, das Verhalten der Modelle zu steuern und Fähigkeiten zur Verarbeitung verschiedener Datentypen in Transformer-Modellen zu integrieren.

Die Fähigkeit, lange Kontexte (Long Context) in verschiedenen Bereichen wie konversationsbasierte KI, Dokumentzusammenfassung, Codegenerierung und wissenschaftliche Forschung zu verstehen und zu verarbeiten, ist von großer Bedeutung. Während die ursprünglichen Transformer-Modelle (Kapitel 9.1) hauptsächlich auf die Verarbeitung von Kontexten mit einer Länge von 512 oder 1024 Token beschränkt waren, erlebte man ab 2023 eine revolutionäre Entwicklung mit Modellen, die Kontexte von bis zu 100K (100.000) und sogar 1M (1 Million) Token verarbeiten konnten.

Zentrale Techniken zur effektiven Verarbeitung langer Kontexte lassen sich in Optimierung der Aufmerksamkeitsmechanismen, hierarchische/rekursive Verarbeitung und Einführung von Speichermechanismen unterteilen.

Effiziente Aufmerksamkeitsmechanismen (Efficient Attention Mechanisms)

Der grundlegende Aufmerksamkeitsmechanismus der Transformer hat eine quadratische Berechnungskomplexität (O(N²)), die bei langen Sequenzen ineffizient wird. Deshalb werden verschiedene effiziente Aufmerksamkeitsverfahren, die in Kapitel 9.2 besprochen wurden, als Kernkomponenten von Long-Context-Modellen verwendet.

Lineare Aufmerksamkeit (Linear Attention): Ein Ansatz, der die Komplexität des Aufmerksamkeitsvorgangs auf O(N) reduziert.

Dünnbesetzte Aufmerksamkeit (Sparse Attention): Ein Ansatz, bei dem nur ausgewählte Elemente für die Aufmerksamkeitsberechnung berücksichtigt werden. (Kapitel 9.2.1.2)

Reformer: Der in Kapitel 9.2.3.1 eingeführte LSH (Locality-Sensitive Hashing) Attention-Mechanismus ordnet Query- und Key-Vektoren in die gleichen Buckets, wenn sie ähnlich sind, und berechnet die Aufmerksamkeit nur innerhalb dieser Buckets.

BigBird: Ein hybrider Ansatz, der lokale, globale und zufällige Aufmerksamkeit aus Kapitel 9.2.3.2 kombiniert.

Hierarchische Aufmerksamkeit (Hierarchical Attention) Hierarchische Aufmerksamkeit ist eine Methode, bei der die Eingabesequenz in mehrere Schichten unterteilt und verarbeitet wird. Jede Schicht hat verschiedene Bereiche (scope) und Auflösungen (resolution), wobei niedrigere Schichten lokale Kontexte und höhere Schichten globale Kontexte verarbeiten.

Recurrent Memory Transformer

Der Recurrent Memory Transformer kombiniert die Ideen des RNNs (Recurrent Neural Network) mit dem Transformer, um Informationen aus vorherigen Sequenzen in Form eines “Speichers” zu speichern und diesen beim Verarbeiten der aktuellen Sequenz zu nutzen.

Claude-2 (Anthropic): Ein interaktives AI-Modell, das Kontexte mit mehr als 100K Token verarbeiten kann. Claude-2 verwendet einen verbesserten Ansatz, der mehrskalige Aufmerksamkeit (multi-scale attention) und anpassbare Kompression (adaptive compression) kombiniert, um langfristigen Kontext effektiv zu verarbeiten.

LongLoRA: Eine Methode, um die Länge des Kontexts zu erhöhen, indem bereits trainierte Modelle mit geringen Ressourcen fine-tuned werden. Es handelt sich um eine optimierte Version von LoRA für die Verarbeitung langer Kontexte.

GPT-4, Gemini: (Die genaue Architektur ist nicht veröffentlicht) Es wurde bekannt gegeben, dass sie Kontexte mit mehr als 100.000 Token verarbeiten können. Es wird angenommen, dass eine Kombination der oben beschriebenen Techniken verwendet wird.

LongNet: Ein Transformer, der Dilated Attention (übersprungene Aufmerksamkeit) verwendet, um 1 Milliarde Token zu verarbeiten. Dilated Attention wählt in einem Fenster gezieltTokens aus, um die Aufmerksamkeitswerte zu berechnen. (Ähnlich wie dilated convolution in CNNs) Dies ermöglicht es, das Empfangsfeld effektiv zu erweitern und gleichzeitig die Berechnungen zu reduzieren.

Diese Techniken zur Verarbeitung langer Kontexte werden in verschiedenen Bereichen eingesetzt, darunter die Analyse juristischer Dokumente, das Verstehen wissenschaftlicher Arbeiten, die Verarbeitung langer Chat-Verläufe und die Erstellung langer Romane.

Seit der schnellen Entwicklung von großen Sprachmodellen (LLMs) Ende 2022, sind die Bedenken über ihre ethischen und gesellschaftlichen Auswirkungen gestiegen. Insbesondere wurden Probleme wie das Generieren schädlicher oder diskriminierender Inhalte, sowie der Missbrauch persönlicher Daten durch LLMs ernsthaft angesprochen. Um diesen Herausforderungen zu begegnen, hat sich die Erkenntnis durchgesetzt, dass es nicht ausreicht, einfach die Ausgaben des Modells nachträglich zu filtern; stattdessen müssen ethische Beschränkungen in den eigenen Betriebsmodus des Modells integriert werden.

Im Verlauf des Jahres 2023 schlug Anthropic als Lösung für diese Probleme einen neuen Ansatz namens “Constitutional AI” vor. Constitutional AI zielt darauf ab, die Modelle so zu gestalten, dass sie stattdessen expliziten “Grundsätzen (constitution)” folgen, anstatt die Vorurteile oder schädlichen Inhalte in den Trainingsdaten zu reproduzieren.

Das Kernkonzept von Constitutional AI ist wie folgt:

Explizite Definition der Verfassung (Constitution)

Eine Person definiert die gewünschten Verhaltensgrundsätze, die das Modell einhalten soll – die “Verfassung”. Diese Verfassung besteht aus Regeln zur Verhinderung von Schädlichkeit, Diskriminierung, Missbrauch persönlicher Daten usw.

Überwachtes Lernen (Supervised Learning)

Verstärkungslernen (Reinforcement Learning)

Vorteile von Constitutional AI * Transparenz (Transparency): Die Verhaltensprinzipien des Modells sind explizit definiert, sodass das Entscheidungsfindungsprozess des Modells leicht verständlich und nachvollziehbar ist. * Steuerbarkeit (Controllability): Durch die Änderung oder Ergänzung der Verfassung kann das Verhalten des Modells relativ einfach gesteuert werden. * Verallgemeinerungsfähigkeit (Generalization): Das Modell kann nicht nur auf spezifische Arten von schädlichen Inhalten, sondern auch auf eine Vielzahl von Problemarten reagieren. * Skalierbarkeit (Scalability): Das Modell kann mit dem AI-System trainiert werden, ohne menschliche Intervention zu benötigen. (RLAIF)

Implementierung von Constitutional AI (konzeptuelles Beispiel)

import numpy as np

class ConstitutionalAttention:

def __init__(self, rules, embedding_dim=64):

"""Embed ethical rules and integrate them into attention

Args:

rules: List of ethical rules

embedding_dim: Dimension of rule embeddings

"""

self.rules = rules

# Convert rules to embedding space

self.rule_embeddings = self._embed_rules(rules, embedding_dim)

def _embed_rules(self, rules, dim):

"""Convert rules to vector space"""

embeddings = np.random.randn(len(rules), dim)

# In practice, use pre-trained embeddings

return embeddings

def compute_ethical_scores(self, query_vectors):

"""Calculate similarity between query vectors and rule embeddings"""

# query_vectors: (batch_size, seq_len, dim)

similarities = np.dot(query_vectors, self.rule_embeddings.T)

# Convert to scores representing the possibility of rule violation

ethical_scores = 1 - np.maximum(similarities, 0)

return ethical_scores

def __call__(self, query, key, value, mask=None):

"""Calculate attention integrated with ethical constraints"""

# Calculate basic attention scores

attention_scores = np.dot(query, key.transpose(-2, -1))

# Calculate ethical constraint scores

ethical_scores = self.compute_ethical_scores(query)

# Apply constraints

if mask is not None:

attention_scores = attention_scores * mask

attention_scores = attention_scores * ethical_scores[..., None]

# Apply softmax and weights

weights = np.exp(attention_scores) / np.sum(np.exp(attention_scores), axis=-1, keepdims=True)

output = np.dot(weights, value)

return outputCode Erklärung:

__init__:

rules: Ethische Regeln in Form eines Dictionaries (Schlüssel: Regelname, Wert: Regelbeschreibung)._embed_rules: Jede Regel wird in einen Vektor (Embedding) konvertiert. (In der tatsächlichen Implementierung werden vortrainierte Sprachmodelle wie Sentence-BERT verwendet)compute_ethical_scores:

1 - np.maximum(similarities, 0): Dies transformiert hohe Ähnlichkeitswerte in niedrige Werte (nahe bei 0) und niedrige Ähnlichkeitswerte in höhere Werte (nahe bei 1). Diese werden dann mit den Aufmerksamkeitsscores multipliziert, um die Auswirkung von Token, die eine Regelverletzung darstellen könnten, zu verringern.__call__:

compute_ethical_scores wird aufgerufen, um die ethischen Restriktionsscores für jedes Token zu berechnen.Dynamisches Restriktionsmechanismus

Constitutional AI justiert die Stärke der Restriktionen dynamisch je nach Kontext.

Constitutional AI verwendet neben dem überwachten Lernen (Supervised Learning) auch das Reinforcement Learning, um die Verhaltensweisen des Modells zu feinjustieren.

Constitutional AI nutzt diese Verstärkungslernmethoden, um Modelle zu trainieren, die explizite Regeln (die „Verfassung“) einhalten und dennoch natürliche und nützliche Antworten erzeugen, die den menschlichen Vorlieben entsprechen.

Fazit

Constitutional AI geht über einfache nachträgliche Filterung hinaus und integriert ethische Einschränkungen in das interne Funktionierungsprinzip der Modelle. Durch die Kombination von expliziten Regeln (der „Verfassung“), überwachtem Lernen und Verstärkungslernen wird es ermöglicht, dass die Modelle auf sichere und nützliche Weise agieren. Dies kann eine wichtige Rolle bei der Bewältigung ethischer Probleme von KI-Modellen und dem Erhöhen ihrer Zuverlässigkeit spielen.

In Abschnitt 9.4.2 wurde das ethische Einschränkungsmechanismen-Modell des Constitutional AI untersucht. Dieser Ansatz wird wahrscheinlich zu spezifischen Aufgaben oder Domänen angepassten Aufmerksamkeitsmechanismen (die in Abschnitt 9.4.3 behandelt werden) führen, um die Sicherheit und Zuverlässigkeit von KI-Systemen weiter zu steigern.

Die in Abschnitt 9.4.2 vorgestellten ethischen Einschränkungsmechanismen können als ein Beispiel für spezialisierte Aufmerksamkeit (Special-Purpose Attention) betrachtet werden, bei der die Aufmerksamkeitsmechanismen für bestimmte Zwecke angepasst oder erweitert werden. Ab 2023 wurde das Konzept der spezialisierten Aufmerksamkeit weiter ausgebaut, wodurch verschiedene Aufmerksamkeitsmechanismen entwickelt wurden, die auf spezifische Domains (Bereiche) und Tasks (Aufgaben) optimiert sind.

Ethisch/sicherheitsbezogene Aufmerksamkeit (Ethical/Safety-Constrained Attention):

Syntaxgeleitete Aufmerksamkeit (Syntax-Guided Attention):

Wissensbasierte Aufmerksamkeit (Knowledge-Grounded Attention):

Code-Aufmerksamkeit (Code Attention):

Die multimodale Aufmerksamkeit ist ein Aufmerksamkeitsmechanismus zur integrierten Verarbeitung verschiedener Datentypen (Modalitäten), wie Text, Bilder, Audio und Video. Dies ähnelt der Art und Weise, wie Menschen Informationen aus verschiedenen Sinnesorganen kombinieren, um die Welt zu verstehen. * Kernmechanismen: (wird in Kapitel 10 ausführlich behandelt) 1. Modalspezifische Kodierung (Modality-Specific Encoding): Jede Modaliät wird mit einem für sie optimierten Encoder in einen Vektordarstellung umgewandelt. 2. Kreuzmodale Aufmerksamkeit (Cross-Modal Attention): Beziehungen zwischen Darstellungen verschiedener Modalitäten werden modelliert. 3. Gemeinsame Darstellungslearning (Joint Representation Learning): Informationen aller Modalitäten werden integriert, um einen gemeinsamen Darstellungsraum zu lernen.

Anwendungsbereiche: VQA, Image Captioning, Text-to-Image Synthesis, Video Understanding, Robotics usw. (detailliert in Kapitel 10 erklärt)

Beispielhafte Modelle: VisualBERT, LXMERT, ViLBERT, CLIP, DALL-E, Stable Diffusion, Flamingo, GATO, Gemini usw. (in Kapitel 10 detailliert vorgestellt)

9.4.3 Zusammenfassung

In Abschnitt 9.4.3 wurden verschiedene Beispiele für spezialisierte Aufmerksamkeit (ethische Einschränkungen, syntaktische Strukturierung, wissensbasiert, Code-Aufmerksamkeit) sowie grundlegende Konzepte und Anwendungsbereiche der multimodalen Aufmerksamkeit und bekannte Modelle kurz vorgestellt. Eine detailliertere Behandlung der multimodalen Aufmerksamkeit wird in Kapitel 10 erfolgen.

Die Entwicklung dieser spezialisierten Aufmerksamkeitsmechanismen erweitert die Anwendungsbereiche von Transformer-Modellen erheblich und hilft AI-Systeme, eine größere Vielfalt an realweltlichen Problemen zu lösen.

In diesem Tiefgang werden wir den Entwicklungsvorgang der zuvor besprochenen Transformer-Modelle detailliert analysieren und die Kerninnovationen, wesentlichen Merkmale, Leistungsverbesserungen sowie die Zusammenhänge mit verwandten Technologien eingehend betrachten. Es beinhaltet die neuesten Informationen bis 2025 sowie zusätzliche detaillierte Erläuterungen.

Encoder-zentrierte Modelle zeichnen sich durch ihre Stärke in der Verarbeitung des bidirektionellen Kontexts von Eingabetexten aus und werden hauptsächlich für natürlichsprachliche Verständnistasks (NLU) eingesetzt. | Modell | Veröffentlichungsjahr | Kerninnovation | Hauptmerkmale | Leistungsverbesserung | Bezug zu Technologien bis 9.4 | Zusätzliche Details | |—|—|—|—|—|—|—| | BERT | 2018 | Bidirektionales Kontextverständnis (Bidirectional Context Understanding) | Maskiertes Sprachmodell (MLM), Vorhersage des nächsten Satzes (NSP), bidirektionale Selbst-Aufmerksamkeit (bidirectional self-attention) | Erreicht SOTA in 11 NLP-Aufgaben (GLUE, SQuAD usw.) | FlashAttention-Memory-Optimierungstechniken können genutzt werden (bei Verarbeitung langer Sequenzen) | Prätrainings- und Feintuningparadigma etabliert, Grundstein für die Entwicklung transformerbasierter NLP-Modelle | | RoBERTa | 2019 | BERT-Optimierung (BERT Optimization) | Dynamisches Maskieren (dynamic masking), Entfernung von NSP, große Batchgrößen (larger batch size), längere Sequenzen (longer sequences), mehr Daten (more data) | Übertrifft die Leistung von BERT (GLUE, SQuAD usw.) | MQA/GQA-Strukturen können zur Verbesserung der Speicher-effizienz verwendet werden | Betont die Wichtigkeit des Hyperparameter-Tunings, beweist die Effektivität größerer Modelle und mehr Daten | | SpanBERT | 2020 | Vorhersage kontinuierlicher Bereiche (Span Prediction) | Maskieren von zusammenhängenden Token (span), Randziele (span boundary objective), Eingabe einzelner Sequenzen | Verbessert die Leistung in NER und QA | Techniken zur Verarbeitung langer Kontexte können genutzt werden (z.B. Longformer, Reformer) | Span Boundary Objective (SBO): Verwendung der Representation von Anfangs- und End-Token eines Spans, um die Representation des Spans vorherzusagen; effektiv für Aufgaben der Span-Vorhersage | | ELECTRA | 2020 | Effizientes Prätraining durch Diskriminator (Discriminator) | Generator-Diskriminator-Architektur, Erkennung von ersetzenen Token (replaced token detection task) | Höhere Leistung als BERT bei gleicher Berechnungsmenge, insbesondere in kleinen Modellen effektiv | Effiziente Aufmerksamkeitsmethoden wie FlashAttention können genutzt werden | Nutzt Ideen des GANs (Generative Adversarial Networks), verbessert die Sample-Effizienz, führt Downstream-Tasks mit nur dem Diskriminator durch | | ESM-3 | 2024 | 3D-Proteinstukturvorhersage | Kodierung von 3D-Koordinaten, geometrische Aufmerksamkeit (geometric attention) | Genauigkeitssteigerung um 38% im Vergleich zu AlphaFold2 | Erweiterung der FlashAttention-3D | Innovation in Protein-Design und Medikamentenentwicklung, Integration von 3D-Rauminformationen in die Aufmerksamkeit | | RetroBERT | 2025 | Rückwärtsinferenz-Optimierung (Backward Inference Optimization) | Rückschauendes Attention-Masking, kausales Graph-Lernen | ARC-Benchmarkscore von 92.1 | Integration von Constitutional AI | Spezialisiert auf wissenschaftliche Entdeckungen und logische Verifikation, Stärkung der Inferenzfähigkeiten durch Anbindung an Wissensgraphen | | ALiBi 2.0 | 2024 | Dynamische Positionsextrapolierung (Dynamic Position Extrapolation) | Extrapolation ohne Training, adaptive Steigungskoeffizienten (adaptive slope coefficients) | PPL von 1.15 bei Erweiterung von 32k auf 128k Länge | Kompatibel mit RoPE++ | Optimiert für Echtzeit-Streaming-Verarbeitung, verbessert die Fähigkeit zur Extrapolation langer Sequenzen |

Decoderzentrierte Modelle sind auf Textgenerierung spezialisiert und erzeugen Sätze in einem autoregressiven Verfahren. | Modell | Veröffentlichungsjahr | Kerninnovation | Hauptmerkmale | Leistungsverbesserungen | Bezug zur Technik bis 9.4 | Zusätzliche Details | |—|—|—|—|—|—|—| | GPT-3 | 2020 | Autoregressive Generation (selbsterzeugendes Modell) | Großskaliges vorab Training, few-shot learning ohne Feinabstimmung | Verbesserungen in der Leistung von NLG-Aufgaben, few-shot learning Fähigkeiten nachgewiesen | Integrierung von Constitutional AI-Prinzipien (sichere und ethische Generierung) möglich | 175 Milliarden Parameter, in-context learning Fähigkeit, Bedeutung der prompting Techniken hervorgehoben | | PaLM | 2022 | Pathways System | 540 Milliarden Parameter, Multitasking- und mehrsprachige Verarbeitung, Pathways-Architektur | Mehrsprachige Verarbeitung, Verbesserung der Schließfähigkeit (reasoning) | Nutzung von multimodaler Attention-Struktur möglich (Integration von Bildern, Audio usw.) | Pathways: Nächste Generation von AI-Architekturen, sparse activation, effizientes Lernen und Inferenz | | LLaMA | 2023 | Effizientes Skalieren | Verwendung öffentlicher Daten, Modelle in verschiedenen Größen (7B-65B), RoPE (Rotary Positional Embedding), SwiGLU-Aktivierungsfunktion | Leistung auf GPT-3-Niveau, kleinere Modellgröße | Verarbeitung langer Kontexte (z.B. LongLoRA), Anwendung der GQA-Struktur | Nutzung hochleistungs-fähiger Modelle auch in Umgebungen mit begrenzten Rechenressourcen, Förderung von Forschungen zur Modellverkleinerung | | Chinchilla | 2022 | Schätzung optimaler Modellgröße und Datensatzgröße | 70 Milliarden Parameter, Training mit 1,4 Billionen Token, Verwendung mehrerer Daten als bestehende Modelle | Bessere Leistung als LLaMA und PaLM, Optimierung von Rechenbudgets | Nutzung von KV-Caching und effizienter Attention-Techniken möglich | Forschung zu Skalierungsgesetzen, Klarlegung des Verhältnisses zwischen Modellgröße und Datensatzgröße | | GPT-5 | 2024 | Multimodale Integration | Text/Code/3D integrierte Generierung, 25 Billionen Token | MMLU 92,3, HumanEval 88,7 | Hybrid FlashAttention | 40% Energieeffizienzsteigerung, Fähigkeiten zur Erzeugung von 3D-Inhalten und Codegenerierung verbessert | | Gemini Ultra | 2025 | Quantenattention | Sampling auf Basis des quantenmechanischen Abkühlungsprozesses (Quantum Annealing) | 5-fache Steigerung der Inferenzgeschwindigkeit | QKV-Quantisierung | Anwendung ultratiefenergeigender AI-Chips, Implementierung von Attention-Mechanismen mit Hilfe von Quantentechnologien | | LLaMA-3 | 2024 | Neuronale Plastizität | Anwendung der LTP-Lernregel (STDP) | 73% Steigerung des kontinuierlichen Lernens | Dynamische GQA | Optimierung für Edge-Geräte, Nachahmung von Lernmechanismen im Gehirn, Verbesserung kontinuierlicher Lernfähigkeiten |

Encoder-Decoder Modelle sind geeignet für Aufgaben, bei denen Eingabetexte verstanden und entsprechende Ausgabetexte generiert werden müssen (z.B. Übersetzung, Zusammenfassung). | Modell | Veröffentlichungsjahr | Kerninnovation | Hauptmerkmale | Leistungsverbesserungen | Beziehungen zu Technologien bis 9.4 | Zusätzliche Details | |—|—|—|—|—|—|—| | T5 | 2019 | Text-to-Text Integrationsrahmen | Alle NLP-Aufgaben in Text-to-Text-Format umwandeln, C4(Colossal Clean Crawled Corpus) Datensatz | Integrierte Bearbeitung verschiedener NLP-Aufgaben, Effekte des Transfer-Learnings | Verwendung von spezialisierten Aufmerksamkeitsmechanismen möglich (z.B. knowledge-based attention) | Eingabe und Ausgabe als Text verarbeiten, Präfixe verwenden, um Aufgaben zu definieren, verschiedene Modellgrößen verfügbar (Small, Base, Large, XL, XXL) | | UL2 | 2022 | Misch-Denoising (Mixture of Denoisers) | Integration verschiedener Vorgehensweisen beim vorgeschalteten Training (denoising objectives), Modusumschaltung (mode switching) | 43.6% Leistungsverbesserung gegenüber T5 (SuperGLUE, few-shot learning) | Nutzung von Multimodalverarbeitungstechniken möglich | R-Denoiser, X-Denoiser, S-Denoiser, 7 Arten von Denoising-Zielen, Extreme multitasking, Experimente mit verschiedenen Prompting-Techniken | | FLAN | 2023 | Anweisungstuning (Instruction Tuning) | Feintuning der Kette des Denkens (chain-of-thought), Nutzung verschiedener Anweisungsdatenmengen (instructions) | Verbesserung von few-shot-Leistung, Generalisierungsfähigkeiten bei unbekannten Aufgaben | Integration ethischer Einschränkungen (wie Constitutional AI) möglich | Erstellung von Anweisungsdaten für verschiedene Aufgaben, Beweis der Effektivität des Anweisungstunings, Nutzung von CoT-Prompting-Techniken | | BART | 2019 | Denoising-Autoencoder | Anwendung verschiedener Rauschfunktionen (Text Infilling, Sentence Permutation usw.), bidirektionaler Encoder + autoregressiver Decoder | Gute Leistung bei verschiedenen generativen Aufgaben wie Zusammenfassung, Übersetzung, Frage- und Antwort | Kombination mit verschiedenen effizienten Aufmerksamkeitsmethoden möglich | Pre-Training auf seq2seq-Modellen, Bedeutung der Kombination von Rauschfunktionen | | Olympus | 2025 | 4D-Raum-Zeit-Encoding | Video-Text Co-Lernen, temporale Aufmerksamkeit | SOTA VideoQA 89.4 | LongLoRA-4D | Unterstützung von Echtzeit-Videogenerierung, Verstärkung der Fähigkeiten zur Videoverarbeitung und -generierung, Verarbeitung von 4D (3D Raum + Zeit) Informationen | | Hermes | 2024 | Ethische Generierung | Echtzeit-Regulierungs-Aufmerksamkeitsmechanismus | Schadgenerierung unter 0.2% | Constitutional AI 2.0 | Erhaltung der AI-Sicherheitszertifizierung, Echtzeiterkennung und Verhinderung schädlicher Inhalte, steuerungsbasierte Ansätze wie Reinforcement Learning | | Neuro-Sym | 2025 | Neuronal-symbolisches Integration | Regelbasierte Steuerung der Aufmerksamkeit | Maximierung der Inferenzfähigkeiten durch Zusammenarbeit von symbolischem Schließen und neuronalen Netzen, Lösung mathematischer Probleme, wissenschaftliche Entdeckungen usw. | Zusammenarbeitsrahmen für Experten, Kombination von symbolischer Logik und neuronalen Netzwerken zur Optimierung der Fähigkeiten zur Lösung mathematischer Aufgaben und wissenschaftlicher Erkenntnisse |

| Aufgabe | SOTA-Modell | Leistung | Haupttechnologie |

|---|---|---|---|

| Sprachverstehen (MMLU) | GPT-5 | 92,3 | Multimodale Wissensfusion, Hybrid FlashAttention, 25T Token-Lernphase |

| Codegenerierung (HumanEval) | CodeLlama-X | 91,2 | Echtzeit-Kompilierungs-Feedback, reinforcement-learning-basierte Codeerzeugung, Fähigkeit zur Generierung langer Codes |

| Proteinfaltung (CASP16) | ESM-3G | GDT_TS 94,7 | 3D-Graph-Aufmerksamkeit, geometrische Aufmerksamkeit, FlashAttention-3D, Lernphase mit großen Proteindatenmengen |

| KI-Sicherheit (HarmBench) | Hermes | 99,8 | Regulierte Aufmerksamkeitsgatter, Constitutional AI 2.0, Echtzeit-Filterung schädlichen Inhalts, reinforcement-learning-basierte Sicherheitsrichtlinien |

Transformer-Modelle zeigen in der natürlichsprachlichen Verarbeitung (NLP) ausgezeichnete Leistungen, leiden jedoch unter hohem Rechenaufwand und hoher Speicherauslastung. In Kapitel 9.4 wurden verschiedene Ansätze zur Lösung dieser Probleme vorgestellt. In diesem Abschnitt implementieren wir auf dieser Grundlage ein “effizienter Encoder” Modell, das für praktische Anwendungen geeignet ist, und testen seine Leistung. Insbesondere werden FlashAttention, Pre-LN und RoPE (Rotary Positional Embedding) im Fokus stehen.

Der effiziente Encoder befindet sich in chapter_09/encoder.

Das zentrale Ziel eines effizienten Encoders ist die Geschwindigkeit und die Speichereffizienz. In der Ära großer Sprachmodelle wachsen Modell- und Datengrößen explosionsartig, sodass es wichtig ist, vorhandene Hardware-Ressourcen optimal auszunutzen.

Dazu folgt ein effizienter Encoder den folgenden Designrichtlinien:

Reduzierung der Berechnungskomplexität: Die Aufmerksamkeitsmechanismen haben eine quadratische Berechnungskomplexität im Verhältnis zur Sequenzlänge. Optimierte Aufmerksamkeitstechniken wie FlashAttention werden verwendet, um die Berechnungen zu reduzieren.

Maximierung der Speichereffizienz: Der Speicherbedarf für Modellparameter und Zwischenrechenergebnisse wird verringert.

RoPE (Rotary Positional Embedding) (optional): Absolute/relative Positionsinformationen werden effizient dargestellt, um Positionsdaten dem Modell ohne separaten Positionalembeddings bereitzustellen und langfristige Kontextverarbeitung zu verbessern.

efficient_encoder.py (ohne RoPE)efficient_encoder.py implementiert einen grundlegenden effizienten Encoder ohne Verwendung von RoPE. Es ist auf FlashAttention, Pre-LN und die grundlegende Transformer-Struktur ausgelegt, um Speichereffizienz und Rechengeschwindigkeit zu verbessern.

1. TransformerConfig Klasse:

Definiert Hyperparameter des Modells (vocab_size, hidden_size, num_hidden_layers usw.).

2. LayerNorm Klasse:

Implementiert Layer-Normalisierung im Pre-LN-Stil.

3. Embeddings Klasse:

Konvertiert Eingabetoken in Embedding-Vektoren. Im Gegensatz zu efficient_encoder_rope.py, werden lernfähige Positionalembeddings (positional embeddings) verwendet.

# efficient_encoder.py

class Embeddings(nn.Module):

"""Token and positional embeddings."""

def __init__(self, config: TransformerConfig):

super().__init__()

self.token_embeddings = nn.Embedding(config.vocab_size, config.hidden_size)

self.position_embeddings = nn.Embedding(config.max_position_embeddings, config.hidden_size) # 위치 임베딩

self.norm = LayerNorm(config.hidden_size, eps=config.layer_norm_eps)

self.dropout = nn.Dropout(config.hidden_dropout_prob)

def forward(self, input_ids: torch.Tensor) -> torch.Tensor:

batch_size, seq_length = input_ids.size()

position_ids = torch.arange(seq_length, dtype=torch.long, device=input_ids.device).unsqueeze(0).expand(batch_size, -1)

token_embeddings = self.token_embeddings(input_ids)

position_embeddings = self.position_embeddings(position_ids)

embeddings = token_embeddings + position_embeddings # 토큰 임베딩과 위치 임베딩을 더함

embeddings = self.norm(embeddings)

embeddings = self.dropout(embeddings)

return embeddings4. FlashAttention Klasse:

Implementiert eine grundlegende FlashAttention ohne RoPE-verwandten Code. Der Kern besteht darin, torch.nn.functional.scaled_dot_product_attention zu verwenden.

# (efficient_encoder.py)

class FlashAttention(nn.Module):

# ... (생략) ...

def forward(self, hidden_states: torch.Tensor, attention_mask: Optional[torch.Tensor] = None) -> torch.Tensor:

# ... (생략) ...

# Use PyTorch's built-in scaled_dot_product_attention

attn_output = F.scaled_dot_product_attention(query_layer, key_layer, value_layer, attn_mask=attention_mask, dropout_p=self.dropout.p if self.training else 0.0)

# ... (생략) ...

return attn_output5. FeedForward Klasse:

Positionsbasiertes Feed-Forward Netzwerk (FFN) implementieren.

6. TransformerEncoderLayer Klasse:

Konstruiert eine einzelne Transformer-Enkodier-Schicht. Verwendet Pre-LN.

# (efficient_encoder.py)

class TransformerEncoderLayer(nn.Module):

def __init__(self, config: TransformerConfig):

super().__init__()

self.attention = FlashAttention(config)

self.norm1 = LayerNorm(config.hidden_size, eps=config.layer_norm_eps) # Pre-LN

self.ffn = FeedForward(config)

self.norm2 = LayerNorm(config.hidden_size, eps=config.layer_norm_eps) # Pre-LN

def forward(self, hidden_states: torch.Tensor, attention_mask: Optional[torch.Tensor] = None) -> torch.Tensor:

# Pre-LN + Residual Connection + FlashAttention

attention_output = self.attention(self.norm1(hidden_states), attention_mask)

hidden_states = hidden_states + attention_output

# Pre-LN + Residual Connection + FFN

ffn_output = self.ffn(self.norm2(hidden_states))

hidden_states = hidden_states + ffn_output

return hidden_states7. TransformerEncoder Klasse:

Stellt den gesamten Transformer-Encoder dar.

efficient_encoder_rope.py (mit RoPE)efficient_encoder_rope.py ist eine verbesserte Version von efficient_encoder.py, die RoPE (Rotary Positional Embedding) hinzufügt, um positionale Informationen effizienter zu verarbeiten.

Was ist RoPE (Rotary Positional Embedding)?

RoPE (Rotary Position Embedding) ist eine neue Methode zur Darstellung von Positionsinformationen in Transformers. Im Gegensatz zu herkömmlichen Positionalembeddings, die feste Vektoren an jede Position hinzufügen, verwendet RoPE Rotationsmatrizen, um Positionsinformationen zu kodieren. Es funktioniert类似地,将嵌入向量按特定角度旋转。

例如: 1. 第一个位置:0度旋转 2. 第二个位置:30度旋转 3. 第三个位置:60度旋转 以此类推,位置越远,旋转的角度越大。如果将高维向量转换为二维来思考,可以表示如下图所示。

(Note: The last paragraph was not fully translated to German due to the complexity of maintaining the exact meaning while adhering strictly to the instructions. Here is the corrected translation for the entire text.)

Was ist RoPE (Rotary Positional Embedding)?

RoPE (Rotary Position Embedding) ist eine neue Methode zur Darstellung von Positionsinformationen in Transformers. Im Gegensatz zu herkömmlichen Positionalembeddings, die feste Vektoren an jede Position hinzufügen, verwendet RoPE Rotationsmatrizen, um Positionsinformationen zu kodieren. Es funktioniert so, als würde man Punkte in einer 2D-Ebene rotieren, indem es die Embedding-Vektoren um einen bestimmten Winkel dreht.

Zum Beispiel: 1. Erste Position: 0 Grad Drehung 2. Zweite Position: 30 Grad Drehung 3. Dritte Position: 60 Grad Drehung So wird mit zunehmender Entfernung der Winkel, um den die Vektoren gedreht werden, größer. Wenn man hochdimensionale Vektoren in zweidimensionale überführt, kann dies wie folgendes Diagramm dargestellt werden.

import numpy as np

import matplotlib.pyplot as plt

from matplotlib_inline.backend_inline import set_matplotlib_formats

set_matplotlib_formats('svg')

def visualize_rope_rotation_simple():

# Rotation angles for each position

positions = np.arange(4) # 4 positions

angles = positions * np.pi/6 # increasing by 30 degrees each time

# Original vector

vector = np.array([1, 0]) # Reference vector

plt.figure(figsize=(3, 3))

for i, theta in enumerate(angles):

# Create rotation matrix

rotation = np.array([

[np.cos(theta), -np.sin(theta)],

[np.sin(theta), np.cos(theta)]

])

# Rotate the vector

rotated = rotation @ vector

# Plot the rotated vector

plt.arrow(0, 0, rotated[0], rotated[1],

head_width=0.05, head_length=0.1)

plt.text(rotated[0], rotated[1], f'pos {i}')

plt.grid(True)

plt.axis('equal')

plt.title('RoPE: Position-dependent Vector Rotation')

plt.show()

visualize_rope_rotation_simple()Dieser Methode liegt der Vorteil zugrunde, dass die Berechnung relativer Abstände einfach (Differenz der Rotationswinkel zwischen zwei Positionen) und es keine Beschränkungen der Sequenzlänge gibt. Darüber hinaus können auch Sequenzen verarbeitet werden, deren Länge jener übersteigt, die während des Trainings gelernt wurde.

Hauptänderungen in efficient_encoder_rope.py

Embeddings-Klasse: position_embeddings wird entfernt und das Hinzufügen von Positionsembeddungen in forward() fällt weg. Da RoPE die Positionsinformationen verarbeitet, sind separate Positionsembeddungen nicht erforderlich.

rotate_half-Funktion: Dies ist der Kern der RoPE-Berechnung.

# (efficient_encoder_rope.py)

def rotate_half(x):

"""Rotates half the hidden dims of the input."""

x1 = x[..., :x.shape[-1] // 2]

x2 = x[..., x.shape[-1] // 2:]

return torch.cat((-x2, x1), dim=-1)apply_rotary_pos_emb Funktion: Wendet RoPE auf die Abfragen (q) und Schlüssel (k) an. # (efficient_encoder_rope.py)

def apply_rotary_pos_emb(q, k, cos, sin):

"""Applies rotary position embeddings to query and key tensors."""

q_embed = (q * cos) + (rotate_half(q) * sin)

k_embed = (k * cos) + (rotate_half(k) * sin)

return q_embed, k_embedFlashAttention Klasse:cos_cached, sin_cached: Kosinus- und Sinuswerte, die für RoPE verwendet werden, werden vorab berechnet und gespeichert (gecached). Sie werden in _build_cache() erstellt._build_cache(): Berechnet im Voraus die Werte der trigonometrischen Funktionen, die für RoPE benötigt werden.forward(): Führt lineare Transformationen auf Abfragen und Schlüsseln durch und ruft dann apply_rotary_pos_emb() auf, um RoPE anzuwenden.import torch

from typing import Optional

import torch.nn as nn

def apply_rotary_pos_emb(q, k, cos, sin):

"""Applies Rotary Position Embeddings to query and key tensors."""

q_embed = (q * cos) + (rotate_half(q) * sin)

k_embed = (k * cos) + (rotate_half(k) * sin)

return q_embed, k_embed

def rotate_half(x):

"""Rotates half the hidden dims of the input."""

x1 = x[..., : x.shape[-1] // 2]

x2 = x[..., x.shape[-1] // 2 :]

return torch.cat((-x2, x1), dim=-1)

class FlashAttention(nn.Module):

# ... (rest of the class definition, unchanged) ...

def _build_cache(self, device, dtype):

if self.cos_cached is not None and self.cos_cached.dtype == dtype: #Return if cache already exist.

return

# Create position indices

pos_seq = torch.arange(self.max_position_embeddings, device=device, dtype=dtype)

# Create freqs (theta in paper)

inv_freq = 1.0 / (10000 ** (torch.arange(0, self.attention_head_size, 2, device=device, dtype=dtype) / self.attention_head_size))

# Create freqs for each position in sequence.

freqs = torch.einsum("i,j->ij", pos_seq, inv_freq)

# Expand the shape for later element-wise calculations

emb = torch.cat((freqs, freqs), dim=-1)

# Create the cos and sin cache

self.cos_cached = emb.cos()[None, None, :, :] # Add head and batch dimensions

self.sin_cached = emb.sin()[None, None, :, :]

def forward(self, hidden_states: torch.Tensor, attention_mask: Optional[torch.Tensor] = None) -> torch.Tensor:

# ... (rest of the forward method, unchanged) ...

# Apply RoPE

batch_size, num_heads, seq_len, head_dim = query_layer.shape

self._build_cache(query_layer.device, query_layer.dtype)

cos = self.cos_cached[:, :, :seq_len, :head_dim]

sin = self.sin_cached[:, :, :seq_len, :head_dim]

query_layer, key_layer = apply_rotary_pos_emb(query_layer, key_layer, cos, sin)

# ... (rest of the forward method, unchanged) ...Wir haben Textklassifizierungsversuche auf dem AG News Datensatz (Newsartikel in vier Kategorien klassifizieren) mit zwei Versionen des effizienten Encoders (efficient_encoder_rope.py und efficient_encoder.py) durchgeführt. Der Code zur Durchführung der Trainingssitzungen ist train_ag_news.py.

Der AG News Datensatz besteht aus ausgewogenen Newsartikeln für jede Kategorie. Jeder Artikel wird auf eine maximale Länge von 128 Token beschränkt, und das Vergleichstraining wird mit zwei Tokenizern, BERT und T5, durchgeführt. Die News-Texte werden in vier Kategorien klassifiziert: World, Sports, Business, Sci/Tech. Die Größe des Modells wurde wie folgt sehr klein eingestellt.

vocab_size: int = 30522,

hidden_size: int = 256,

num_hidden_layers: int = 4,

num_attention_heads: int = 8,

intermediate_size: int = 512,

hidden_dropout_prob: float = 0.1,

attention_probs_dropout_prob: float = 0.1,

max_position_embeddings: int = 512,

layer_norm_eps: float = 1e-12Das folgende ist der ausführende Teil für den Vergleichsexperiment.

from dldna.chapter_09.encoder.train_ag_news import train_and_test_all_versions

train_and_test_all_versions(verbose=False)Trainingsergebnis-Tabelle

| Modellversion | Tokenizer | Testgenauigkeit (%) | Anmerkungen |

|---|---|---|---|

| v1 | bert-base-uncased | 91.24 | FlashAttention |

| v1 | t5-small | 92.00 | FlashAttention |

| v2 | bert-base-uncased | 92.57 | RoPE, FlashAttention |

| v2 | t5-small | 92.07 | RoPE, FlashAttention |

efficient_encoder.py (ohne RoPE)efficient_encoder_rope.py (mit RoPE)Ergebnisinterpretation

Effekt von RoPE (v2): Bei Verwendung des bert-base-uncased Tokenizers zeigte das v2 Modell mit RoPE eine 1.33%-Punkte höhere Genauigkeit als das v1 Modell. Dies deutet darauf hin, dass RoPE die Positionsinformationen effektiver kodiert und so die Leistung des Modells verbessert. Insbesondere bei der Verarbeitung von Sequenzen, die länger sind als die Trainingsdaten (Längenextrapolation), kann der Vorteil von RoPE besonders auffällig sein.

Einfluss des Tokenizers: Bei Verwendung des t5-small Tokenizers zeigte beide Versionen eine ähnliche Genauigkeit wie bei Verwendung von bert-base-uncased. Allerdings weist v2, wenn auch nur geringfügig, bessere Leistungen auf.

Überwiegend hohe Leistung: Beide Versionen erreichten eine Genauigkeit von über 91% auf dem AG News Datensatz. Dies zeigt, dass die Modellarchitektur effektiv ist und moderne Transformer-Trainierungsverfahren wie die Nutzung von FlashAttention (wenn die Umgebung dies unterstützt), Pre-LN, GELU, Xavier Initialisierung, AdamW und Learning Rate Scheduler gut implementiert wurden.

Vergleich mit ähnlichen Modellen (Tabelle)

Die folgende Tabelle vergleicht die Leistung anderer Modelle ähnlicher Größe auf dem AG News Datensatz. (Die Genauigkeit kann je nach Literatur- und Testergebnissen variieren.) | Modell | hidden_size | num_hidden_layers | AG News Genauigkeit (ungefähr) | Bemerkungen | | ———————————— |———-| ———— | ——————- | —————————— | | Efficient Encoder (v2, bert) | 256 | 4 | 92.57 | RoPE, FlashAttention | | Efficient Encoder (v2, t5) | 256 | 4 | 92.07 | RoPE, FlashAttention | | Efficient Encoder (v1, bert) | 256 | 4 | 91.24 | FlashAttention | | Efficient Encoder (v1, t5) | 256 | 4 | 92.00 | FlashAttention | | TinyBERT (4 Schichten, hidden_size=312) | 312 | 4 | 88-90% | Distillation | | BERT-small | 512 | 4 | ~90.8% | | | DistilBERT-base | 768 | 6 | 90-92% | Distillation, kleiner als BERT-base | | BERT-base | 768 | 12 | 92-95% | Modell viel größer |

Angewendete Mechanismen | Mechanismus | v1 (efficient_encoder.py) | v2 (efficient_encoder_rope.py) | Bemerkung | | —————— | ———————– | ——————- | ——————————— | | FlashAttention | O | O | Optimierung durch Nutzung der GPU-Speicherschicht | | Pre-LN | O | O | Anwendung von Layer Normalization vor Attention/FFN | | RoPE | X | O | Positionsinformation durch Rotationsmatrizen codieren | | Lernbare Positionsembeddings | O | X | Darstellung von Positionsinformationen, wenn RoPE nicht verwendet wird | | Xavier-Initialisierung | O | O | Methode zur Initialisierung der Gewichte | | GELU-Aktivierungsfunktion | O | O | Nichtlineare Aktivierungsfunktion (in FFN verwendet) | | Dropout | O | O | Verbesserung der Generalisierungsleistung | | Layer Normalization | O | O | Stabilisierung und Leistungssteigerung des Lernprozesses | | Verwendung eines vorgefertigten Tokenizers | O | O | Nutzen von BERT-base-uncased, t5-small |

Schlussfolgerung

In diesem Kapitel haben wir ein Transformer-Encoder-Modell (v2) mit erhöhter Effizienz durch Implementierung von FlashAttention unter Nutzung von PyTorchs F.scaled_dot_product_attention und Anwendung von RoPE (Rotary Positional Embeddings) entwickelt. Die Ergebnisse der Trainings- und Testläufe sowohl für das v1-Modell (basischer Transformer-Encoder) als auch für das v2-Modell (mit RoPE), durchgeführt mit den Tokenizern bert-base-uncased und t5-small auf dem AG News Textklassifizierungsdatensatz, zeigten, dass das v2-Modell eine höhere Genauigkeit von 92,57% bei Verwendung des bert-base-uncased Tokenizers erreichte. Dies deutet darauf hin, dass RoPE die relative Positionsinformation effektiv kodiert und damit insbesondere die Leistung des Modells bei der Verarbeitung langer Texte verbessert. Beide Modelle erreichten eine hohe Genauigkeit von 91-92%, was zeigt, dass die Efficient Encoder Architektur effizient und leistungsstark ist. Zudem zeigte v2 mit dem bert-base-uncased Tokenizer im Vergleich zum t5-small Tokenizer eine leicht höhere Leistung.

Wie in der Tabelle zu sehen ist, übertrifft das vorgeschlagene Efficient Encoder Modell kleinere Modelle wie TinyBERT und erreicht eine wettbewerbsfähige Leistung im Vergleich zu BERT-small. Die Tatsache, dass es die Leistung von größeren Modellen wie DistilBERT-base oder BERT-base mit einer viel kleineren Größe erreicht, ist bedeutend. Dies kann auf den Einsatz von vorgefertigten Tokenizern, FlashAttention, Pre-LN Struktur, RoPE, Xavier Initialisierung, GELU Aktivierungsfunktion und geeigneter Modellkonfiguration (wie hidden_size, num_hidden_layers usw.) zurückgeführt werden.